Abstract

基于运动想象脑电(EEG)的脑-机接口系统能够为用户提供更为自然、灵活的控制方式,已广泛应用到人机交互领域。然而,由于目前运动想象脑电的信噪比及空间分辨率较低,导致信号解码正确率较低。针对这一问题,本文提出一种基于时空特征学习卷积神经网络(TSCNN)的运动想象脑电解码方法。首先,针对经过带通滤波预处理的脑电信号,依次设计时间和空间维度上的卷积层,构造出运动想象脑电的时空特征;然后,利用 2 层二维卷积结构对脑电的时空特征进行抽象学习;最后,通过全连接层和 Softmax 层对 TSCNN 学习的抽象特征进行解码。利用公开数据集对该方法进行实验测试,结果表明,所提方法的平均解码精度达到 80.09%,分别比经典的解码方法共空间模式(CSP) + 支持向量机(SVM)和滤波器组 CSP(FBCSP) + SVM 提高了 13.75% 和 10.99%,显著提升了运动想象脑电解码的可靠性。

Keywords: 运动想象脑电, 脑机接口, 时空特征, 卷积神经网络, 信号解码

Abstract

With the advantage of providing more natural and flexible control manner, brain-computer interface systems based on motor imagery electroencephalogram (EEG) have been widely used in the field of human-machine interaction. However, due to the lower signal-noise ratio and poor spatial resolution of EEG signals, the decoding accuracy is relative low. To solve this problem, a novel convolutional neural network based on temporal-spatial feature learning (TSCNN) was proposed for motor imagery EEG decoding. Firstly, for the EEG signals preprocessed by band-pass filtering, a temporal-wise convolution layer and a spatial-wise convolution layer were respectively designed, and temporal-spatial features of motor imagery EEG were constructed. Then, 2-layer two-dimensional convolutional structures were adopted to learn abstract features from the raw temporal-spatial features. Finally, the softmax layer combined with the fully connected layer were used to perform decoding task from the extracted abstract features. The experimental results of the proposed method on the open dataset showed that the average decoding accuracy was 80.09%, which is approximately 13.75% and 10.99% higher than that of the state-of-the-art common spatial pattern (CSP) + support vector machine (SVM) and filter bank CSP (FBCSP) + SVM recognition methods, respectively. This demonstrates that the proposed method can significantly improve the reliability of motor imagery EEG decoding.

Keywords: motor imagery electroencephalogram, brain-computer interface, temporal-spatial feature, convolutional neural network, signal decoding

引言

机器学习技术能够从脑电图(electroencephalogram,EEG)记录的大脑活动中提取有用信息,因此其在基于 EEG 的脑电研究和应用领域起着至关重要的作用。脑-机接口(brain-computer interface,BCI)系统作为一种新颖的人机交互手段,正是利用机器学习技术解码用户意图从而实现对外部环境或设备的控制,如脑控神经假肢[1]、外骨骼机器人[2]、机械臂[3]和无人机[4]等。

相比于诱发型脑电模态,如稳态视觉诱发电位(steady-state visually evoked potentials,SSVEP)和 P300,运动想象脑电等具有自发性和本质自然性,更适合作为脑-机接口系统的控制信号[5]。当执行单侧肢体运动想象任务时,大脑对侧运动感觉区的神经活动降低,导致 μ 节律(8 ~ 12 Hz)和 β 节律(13 ~ 30 Hz)的频谱能量减小;而大脑同侧运动感觉区的神经活动增强,导致 μ 节律和 β 节律的频谱能量上升,这种电生理现象被称为事件相关去同步(event-related desynchronization,ERD)和事件相关同步(event-related synchronization,ERS)[6]。利用 ERS/ERD 现象,研究者们提出大量的机器学习方法用来解码运动想象脑电信号,包括用于提取时间域、频域和空间域特征的自回归模型、小波变换、频带能量、共空间模式(common spatial pattern,CSP)及其变种等算法[7-10]以及用于分类的线性判别分析、支持向量机(support vector machine,SVM)、BP 神经网络(back propagation neural network,BPNN)、极限学习机等分类器[11-13]。作为一种有效的空间滤波算法,CSP 已成为运动想象 EEG 解码的基准算法,它通过寻找一组最优的空间线性变换,获得具有最大可分性的空间域特征,进而最大化不同运动想象类别之间的距离。但是,该算法仅考虑了 EEG 信号的空间信息,而忽略了其中蕴含丰富的时间信息。此外,CSP 算法需要进行人工的特征提取和选择,以获得最优的空间滤波器,这将导致空间信息的部分损失,进而影响分类效果。

随着深度学习技术的兴起,卷积神经网络(convolutional neural network,CNN)获得广泛关注和极大发展,特别是在计算机视觉[14]和自然语言处理[15]领域取得一系列成功应用。CNN 利用局部感受野的概念,通过分层卷积的结构设计能够从原始特征模态隐式地学习出抽象特征,进而实现自动地特征抽取;另外,CNN 权值共享的特性有效减少了权值的规模,极大地降低了网络模型的复杂程度[16]。相比于手工提取 EEG 信号特征方式,在很大程度上依赖于人工经验和特征选择过程,CNN 无需先验知识就能从原始信号中自动提取和选择出更为丰富、更具表征性的抽象特征,极大地降低了信号中蕴含信息的损失,同时 CNN 在特征提取中更为省时、省力,非常适用于时序 EEG 信号的特征学习和解码。近年来,已有越来越多的文献开展基于 CNN 的运动想象 EEG 解码研究。Tang 等[17]利用设计的 5 层 CNN 对原始运动想象 EEG 信号(左右手两类)进行特征学习和识别,结果显示 CNN 能够有效解码运动想象意图。孔祥浩等[18]提出融合 CSP 与 CNN 的运动想象 EEG 解码方法,将 CSP 算法提取的 EEG 空间域特征作为 CNN 的输入,利用 CNN 网络学习特性对空间域特征进行二次筛选和分类,两类运动想象 EEG 的平均识别率达 88.3%。Pérez-Zapata 等[19]提出将功率谱密度特征输入到 CNN 网络中,实现对左/右手、脚及舌头运动想象 EEG 的分类。Sakhavi 等[20]利用滤波器组 CSP(filter bank CSP,FBCSP)和希尔伯特变换对原始运动想象 EEG 信号进行处理,引入新的时间表征特征,并提出三种 CNN 架构对这些时间特征进行学习和解码,从而提高分类精度。胡章芳等[21]利用短时傅里叶变换提取原始 EEG 的二维时频特征,并设计一维卷积结构的 CNN 网络对时频域特征进行抽取,利用 SVM 对 CNN 提取的特征进行分类,左右手两类运动想象 EEG 的平均识别率为 86.5%。Schirrmeister 等[22]针对四类运动想象脑电信号设计了深层和浅层两种结构的卷积神经网络,并探讨了不同网络参数与学习算法对解码性能的影响。Tabar 等[23]利用短时傅里叶变换将时域脑电信号转换为频域的二维(2 dimensionality,2D)功率谱特征图像,设计了融合 CNN 与堆栈自编码器(stacked autoencoders,SAE)的深度学习网络,左右手运动想象 EEG 的平均解码正确率达 75.1%。上述研究大多数都是对原始 EEG 信号在空间域、时域、频域或时频域进行预先特征提取,并利用 CNN 网络学习预先设定的特征,而没有充分利用原始 EEG 信号含有的时间和空间信息,同时这些研究在设计 CNN 网络结构时忽略了原始 EEG 信号的时空变化特性。

为了充分利用原始 EEG 信号蕴含的时间和空间信息,本文提出一种基于运动想象 EEG 时空特征学习的卷积神经网络解码方法,以实现对原始 EEG 信号的时空特征抽取和识别。本文的贡献主要包括:(1)根据运动想象 EEG 信号特性,在 CNN 网络结构中依次设计时间、空间方向上的卷积层,构造运动想象 EEG 的时空特征;(2)利用 2 层二维卷积结构对脑电的时空特征进行抽象学习;(3)利用优化算法和正则化算法对 CNN 网络结构和参数进行优化。所提方法与其他两种经典识别方法(CSP + SVM 和 FBCSP + SVM)在 BCI 竞赛的公开数据集上分别进行测试,并进行显著性对比分析,以验证本文所提方法的有效性。

1. 数据来源与预处理

1.1. 实验测试数据集

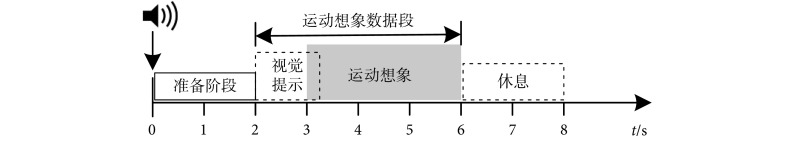

本文研究在 BCI Competition IV-2a 公开数据集(http://www.bbci.de/competition/iv/)上进行实验测试。该数据集由 9 名被试的四类运动想象 EEG 信号组成,包括想象左右手、脚及舌头运动。每名被试进行两组相同的采集实验,通过 22 个 Ag/AgCl 电极以 250 Hz 采样率记录连续的 EEG 信号。在每组实验中,针对每类进行 72 次运动想象任务,共计 288 次。如图 1 所示,单次运动想象任务持续时间为 8 s,前 2 s 为准备阶段,紧接着出现 1.25 s 的视觉提示,指示被试进行相应的运动想象任务至第 6 s 结束,然后被试进行 2 s 的休息以准备下一次运动想象任务。从连续采集的 EEG 数据中我们截取提示后 4 s 的数据作为单次运动想象 EEG 样本,进而针对每个被试构造出大小为 22 × 1 000 × 576 的运动想象 EEG 数据样本集。

图 1.

Experimental sequence of single motor imagery task

单次运动想象任务时序

1.2. 数据预处理

为减少工频干扰,原始 EEG 数据已经过 50 Hz 陷波滤波。因为与运动想象有关的 EEG 节律主要为 μ 节律和 β 节律[6],为进一步提高 EEG 的信噪比,我们采用 4 阶零相位巴特沃斯带通滤波器(8 ~ 30 Hz)对 EEG 数据进行滤波,去除基线漂移、眼动、头动等伪迹干扰。此外,使用 EEGLAB 的 FastICA 工具箱(一种独立元分析算法)对带通滤波后的数据进行处理,以去除肌电、眼电及眨眼等噪声[24]。

2. 运动想象脑电解码方法

2.1. 经典解码方法

EEG 信号反映的是大脑神经元放电在头皮空间分布上的叠加,蕴含丰富的空间信息。而运动想象 EEG 的 ERD/ERS 现象又常常表现出空间差异性。为了从 EEG 信号中提取空间特征,研究者们提出 CSP 算法及其变种(如 FBCSP[25]、PCSP[26]、RCSP[10]等),并结合 SVM 分类器开展运动想象 EEG 的识别工作。因此,本文选择 CSP + SVM 和 FBCSP + SVM 作为基准的经典识别方法,以便后续进行对比性研究。

2.1.1. CSP 算法

CSP 算法一般采用同时对角化方式来寻找一组最优的空间滤波器,实现一类 EEG 样本协方差矩阵的最大化同时另一类 EEG 样本协方差矩阵的最小化。通常,利用解广义特征值方法选取  个最大特征值和

个最大特征值和  个最小特征值对应的特征向量来构造空间滤波器矩阵

个最小特征值对应的特征向量来构造空间滤波器矩阵  。具体的算法过程可参考[10]。根据 CSP 算法可知,如何选取

。具体的算法过程可参考[10]。根据 CSP 算法可知,如何选取  是构造最优空间滤波器的关键。

是构造最优空间滤波器的关键。 越大,保留的空间特征信息越多,同时冗余信息增加,影响训练速度和识别精度;

越大,保留的空间特征信息越多,同时冗余信息增加,影响训练速度和识别精度; 越小,信息损失越多,降低空间域特征的可分性。另外,CSP 算法本质上仅能解决两类问题,对于多类别运动想象 EEG,需要一对一或一对多的策略分别训练出空间滤波器矩阵。本文采用一对多的策略训练出四个 CSP 空间滤波器矩阵,每个 CSP 的

越小,信息损失越多,降低空间域特征的可分性。另外,CSP 算法本质上仅能解决两类问题,对于多类别运动想象 EEG,需要一对一或一对多的策略分别训练出空间滤波器矩阵。本文采用一对多的策略训练出四个 CSP 空间滤波器矩阵,每个 CSP 的  设置为 4,构成最终的空间滤波器矩阵

设置为 4,构成最终的空间滤波器矩阵

。

。

2.1.2. FBCSP 算法

该算法是 CSP 算法的进一步扩展,主要由四个部分组成。首先,使用不同配置的带通滤波器组将 EEG 信号分解到多个子频带;其次,针对每个子频带内的 EEG 信号进行 CSP 计算以提取空间滤波器;然后,将所有子频带提取的空间滤波器组合在一起,并对原始 EEG 信号进行空间滤波;最后,使用 log-variance 计算滤波后信号的空间特征。具体的算法过程可参考文献[25]。本文使用 6 组切比雪夫Ⅱ型带通滤波器将 8 ~ 30 Hz 的 EEG 信号分解到 4 ~ 7、8 ~ 11、12 ~ 15、16 ~ 19、20 ~ 23、24 ~ 27、28 ~ 30 Hz 频带内,并计算出 6 组 CSP 空间滤波器。

SVM 作为一类广义线性分类器,以结构风险和 VC 维(Vapnik-Chervonenkis dimension,VCD)最小化为原则,通过寻找一个具有最大决策边距的高维超平面来区分特征样本,其具有良好的稳健性和泛化能力,非常适合处理小样本 EEG 数据[27]。SVM 的高维超平面可通过求解一个凸二次规划函数获得。另外,由于 EEG 特征样本往往具有非线性特点,因此 SVM 需要使用核函数映射方式来解决非线性分类问题[27]。本文使用径向基核函数设计 SVM 分类器,并通过网格搜索和交叉验证方法寻找最优的核函数参数(带宽  )和正则项

)和正则项  。

。

2.2. 基于时空特征学习的 CNN 解码方法

CSP 算法及其变种提取的仅是 EEG 信号的空间域特征,而忽视了 EEG 信号的时域变化信息。为此,本文提出一种基于运动想象 EEG 时空特征学习的卷积神经网络解码方法(temporal-spatial CNN,TSCNN),利用局部感受野和权值共享的特性,通过设计时间和空间方向上的卷积结构实现对原始运动想象 EEG 信号的时空特征提取,并利用 2 层二维卷积结构对时空特征进行抽象学习。整体网络结构由 4 部分组成(如图 2 所示):第一部分是输入层;第二部分是时间-空间一维卷积-Pooling 模块;第三部分是二维卷积-Pooling 模块;第四部分为全连接层和 Softmax 输出层。图 2 给出的是本文所提 TSCNN 网络的一个示例,其中的网络结构和参数需要进一步优化,包括卷积核大小、卷积步长、Pooling 大小和步长以及各层隐含节点数目等。

图 2.

The architecture of temporal-spatial feature learning CNN (TSCNN)

时空特征学习卷积神经网络架构

(1)输入层:本文使用预处理后的原始运动想象 EEG 数据作为输入,每个 EEG 样本为 22 × 1 000 的数据矩阵,其中 22 为通道数(代表 EEG 的空间信息),1 000 为每个通道记录的采样点(代表 EEG 的时间信息)。

(2)时间-空间一维卷积-Pooling 模块:该模块主要作用是从 EEG 数据中提取初级的时空特征。采用一维卷积结构依次从时间方向和空间方向对 EEG 数据进行卷积运算。为减少参数和防止过拟合风险,卷积层 1 的卷积核大小与卷积步长设置相同,如使用 25 个 1 × 5 的卷积核以 5 步长对 EEG 进行时间方向上的卷积,获得 25 个大小为 22 × 200 的特征图;然后,在空间方向上以大小为 22 × 1 的卷积核进行空间卷积,获得 25 个 1 × 200 的特征图;最后,依次进行平方运算、Mean Pooling 层降采样和对数运算,获得 EEG 样本的时空特征图。本部分各卷积层的激活函数设置为指数线性单元(exponential linear units,ELUs),以提升时间-空间一维卷积-Pooling 模块对 EEG 信号输入噪声的鲁棒性。

(3)二维卷积-Pooling 模块:该模块主要作用是对提取的 EEG 时空特征图进行抽象学习。采用 2 层二维卷积结构对时空特征图进行分层卷积,并利用 Max Pooling 层进行降采样,获得更高级的时空抽象特征,如图 2 所示,40 个 1 × 4 的时空抽象特征图。本部分设置 Max Pooling 层的池化窗口大小和步长相同,同时各卷积层的激活函数设置为修正线性单元(rectified linear units,ReLUs),以降低二维卷积-Pooling 模块计算量、加快收敛速度并且缓解梯度消失和过拟合问题的发生[28]。

(4)全连接层和 Softmax 输出层:该部分主要功能是对学习的时空抽象特征进行分类。首先,将抽取的时空特征图拉直为一个特征向量,输入到全连接层,该层神经元个数设置为 120 个,神经元的激活函数为 ReLU;然后,在输出层利用 Softmax 逻辑回归进行分类,该层神经元个数设置为 4 个,其中每个神经元对应一个运动想象 EEG 类别。

(5)TSCNN 网络训练与优化:为了联合训练 TSCNN 网络的连接权重和偏置,同时实现网络的有效收敛,需要定义一个优化函数,即网络的损失函数。假设 TSCNN 网络可以表示为由输入 EEG 数据  到每类值的映射函数

到每类值的映射函数  ,其中

,其中  为网络的所有待优化参数,

为网络的所有待优化参数, 为输出类别数。利用 Softmax 函数,可以计算出给定输入

为输出类别数。利用 Softmax 函数,可以计算出给定输入  在不同类别标签

在不同类别标签  下的条件概率

下的条件概率  。那么,

。那么, 的优化目标可以定义为最小化所有样本的损失之和。根据反向传播算法,采用小批量随机梯度下降法(mini-batch stochastic gradient descent)对 TSCNN 网络的连接权重和偏置进行更新与优化[28]。另外,为加速网络训练并获得更好的训练效果,在每层卷积前后分别加入批归一化(batch normalization)操作和 50% 概率的 Dropout 操作。

的优化目标可以定义为最小化所有样本的损失之和。根据反向传播算法,采用小批量随机梯度下降法(mini-batch stochastic gradient descent)对 TSCNN 网络的连接权重和偏置进行更新与优化[28]。另外,为加速网络训练并获得更好的训练效果,在每层卷积前后分别加入批归一化(batch normalization)操作和 50% 概率的 Dropout 操作。

2.3. 评价指标及统计方法

在每个被试的运动想象 EEG 数据集上,分别训练 CSP + SVM、FBCSP + SVM 和本文所提 TSCNN 的分类模型。每个被试的数据集分成 60% 的训练集、20% 的验证集和 20% 的测试集。训练集用来构建分类模型,验证集用来优化模型参数,测试集用来评价模型的分类效果。评价指标主要包括:① 针对 3 种解码模型,分别统计各个被试数据的总体识别正确率,即正确预测类别数与总体类别数的比值。② Kappa 系数是一种衡量分类一致性的量值,表征着分类与完全随机的分类产生错误减少的比率,计算公式如下[20, 29]:

|

1 |

其中, 为总体识别正确率,

为总体识别正确率, 为完全随机的分类正确率(对于本文四分类问题,则

为完全随机的分类正确率(对于本文四分类问题,则  )。③ 计算每类识别结果组成的混淆矩阵,该矩阵反映了每类运动想象 EEG 被正确分类的比率以及被错误分类的比率。此外,为了对比 3 种解码方法的显著性差异,我们采用威尔科克符号秩检验(Wilcoxon signed-rank test)进行显著性检验。

)。③ 计算每类识别结果组成的混淆矩阵,该矩阵反映了每类运动想象 EEG 被正确分类的比率以及被错误分类的比率。此外,为了对比 3 种解码方法的显著性差异,我们采用威尔科克符号秩检验(Wilcoxon signed-rank test)进行显著性检验。

3. 实验结果与分析

3.1. TSCNN 网络结构参数选择

针对每个被试的运动想象 EEG 数据集,利用 10 折交叉验证方式对 TSCNN 网络结构的超参数进行选择,主要包括卷积层的卷积核大小和步长、Pooling 层大小和步长以及卷积层节点数目等。为了简化超参数选择过程,我们设定了各层参数的可选范围(如表 1 所示),并采用坐标下降法(coordinate descent)在每次迭代中针对某一个参数进行一维搜索[30]。

表 1. Optional parameter range of the TSCNN network.

TSCNN 网络的可选参数范围

| 各层类型 | 大小/步长 | 卷积层节点数目 |

| 卷积层 1 | {1 × 2/1 × 2};{1 × 3/1 × 3};{1 × 4/1 × 4};{1 × 5/1 × 5} | {25;30;35;40} |

| 卷积层 2 | {22 × 1/1 × 1} | {25;30;35;40} |

| Mean Pooling | {1 × 2/1 × 2};{1 × 4/1 × 4} | |

| 卷积层 3 | {25 × 2/1 × 2};{30 × 2/1 × 2};{35 × 2/1 × 2};{40 × 2/1 × 2}; | {25;30;35;40} |

| Max Pooling-1 | {1 × 2/1 × 2};{1 × 4/1 × 4} | |

| 卷积层 4 | {25 × 3/1 × 2};{30 × 3/1 × 2};{35 × 3/1 × 2 };{40 × 3/1 × 2}; | {25;30;35;40} |

| Max Pooling-2 | {1 × 3/1 × 3};{1 × 4/1 × 4} |

表 2 给出每个被试数据经过交叉验证训练,平均分类正确率最高时的网络结构参数。从表 2 可知,当网络结构配置为卷积层 1:{1 × 5 / 1 × 5};卷积层 2:{22 × 1 / 1 × 1};Mean Pooling 层:{1 × 2 / 1 × 2};卷积层 3:{25 × 2 / 1 × 2};Max Pooling-1:{1 × 2 / 1 × 2};卷积层 4:{30 × 3 / 1 × 2};Max Pooling-2:{1 × 3 / 1 × 3};各卷积层隐含节点数目:{25, 25, 30, 40}时,TSCNN 网络能够获得更好的分类正确率。另外,从卷积层 1 的结构参数看,卷积核及步长越小,网络的识别率越小,这说明卷积层 1 学习的时间特征信息越少,导致网络抽取的时空特征较差,影响网络后续的分类效果。

表 2. The optimized TSCNN network parameters for each participant.

每个被试的 TSCNN 网络优化参数

| 被试 | 网络结构参数 | 识别率 |

| 1 | {1 × 5/1 × 5};{22 × 1/1 × 1};{1 × 2/1 × 2};{25 × 2/1 × 2};{1 × 2/1 × 2};{30 × 3/1 × 2};{1 × 3/1 × 3};{25,25,30,40} | 86.50% |

| 2 | {1 × 4/1 × 4};{22 × 1/1 × 1};{1 × 2/1 × 2};{25 × 2/1 × 2};{1 × 2/1 × 2};{35 × 3/1 × 2};{1 × 3/1 × 3};{25,25,35,35} | 74.08% |

| 3 | {1 × 5/1 × 5};{22 × 1/1 × 1};{1 × 2/1 × 2};{25 × 2/1 × 2};{1 × 2/1 × 2};{30 × 3/1 × 2};{1 × 3/1 × 3};{25,25,30,40} | 92.75% |

| 4 | {1 × 2/1 × 2};{22 × 1/1 × 1};{1 × 4/1 × 4};{30 × 2/1 × 2};{1 × 2/1 × 2};{25 × 3/1 × 2};{1 × 4/1 × 4};{30,30,25,30} | 70.50% |

| 5 | {1 × 2/1 × 2};{22 × 1/1 × 1};{1 × 4/1 × 4};{40 × 2/1 × 2};{1 × 2/1 × 2};{35 × 3/1 × 2};{1 × 4/1 × 4};{40,40,35,25} | 66.60% |

| 6 | {1 × 2/1 × 2};{22 × 1/1 × 1};{1 × 4/1 × 4};{40 × 2/1 × 2};{1 × 2/1 × 2};{35 × 3/1 × 2};{1 × 4/1 × 4};{40,40,35,25} | 62.25% |

| 7 | {1 × 5/1 × 5};{22 × 1/1 × 1};{1 × 2/1 × 2};{25 × 2/1 × 2};{1 × 2/1 × 2};{30 × 3/1 × 2};{1 × 3/1 × 3};{25,25,30,40} | 88.24% |

| 8 | {1 × 5/1 × 5};{22 × 1/1 × 1};{1 × 2/1 × 2};{25 × 2/1 × 2};{1 × 2/1 × 2};{30 × 3/1 × 2};{1 × 3/1 × 3};{25,25,30,40} | 87.09% |

| 9 | {1 × 5/1 × 5};{22 × 1/1 × 1};{1 × 2/1 × 2};{25 × 2/1 × 2};{1 × 2/1 × 2};{30 × 3/1 × 2};{1 × 3/1 × 3};{25,25,30,40} | 92.80% |

3.2. 三种解码方法的结果对比

根据表 2,我们构建出每个被试的 TSCNN 网络结构,并训练出各自的识别模型。同时,在相同的数据集上,分别训练 CSP + SVM 和 FBCSP + SVM 方法的识别模型。本文 CSP + SVM 和 FBCSP + SVM 方法的基本参数如表 3 所示。表 4 给出所有被试在 3 种分类模型下的识别率和相应的 Kappa 系数结果。目前,在 BCI Competition IV-2a 公开数据集上排名第一的竞赛结果为平均分类识别率达 67.75% 和平均 Kappa 系数为 0.570(http://bbci.de/competition/iv/results/),而本文 CSP + SVM 和 FBCSP + SVM 方法获得的结果与之相当,说明训练的 CSP + SVM 和 FBCSP + SVM 识别模型已达到最优结果。从整体上看,与传统的 CSP + SVM 和 FBCSP + SVM 方法相比,本文所提 TSCNN 解码方法能够显著提高 EEG 的识别率和 Kappa 系数。TSCNN 的平均解码精度达到 80.09%,比 CSP + SVM 和 FBCSP + SVM 分别提高了 13.75% 和 10.99%。同时,对于单个被试如 3 和 9,TSCNN 可达到的最高识别率分别为 92.75% 和 92.80%。从统计学角度看,相比于 CSP + SVM 和 FBCSP + SVM 方法,TSCNN 解码方法对识别率具有显著影响(P < 0.01 和 P < 0.05,Wilcoxon signed-rank test)。这说明对于运动想象 EEG 时空特征的学习有助于提升信号的识别率。此外,TSCNN 方法获得的 Kappa 系数大多位于 0.6 ~ 0.9 之间,且均值为 0.735,表明该解码方法具有高度的一致性。然而,CSP + SVM 和 FBCSP + SVM 方法计算的 Kappa 系数均值都小于 0.6,说明这些方法仅具有一般或中等的一致性。类似地,从统计学角度看,相比于 CSP + SVM 和 FBCSP + SVM 方法,TSCNN 解码方法能够显著提升 Kappa 系数(P < 0.001 和 P < 0.001,Wilcoxon signed-rank test)。这进一步验证了本文所提方法的有效性。

表 3. The basic parameters for the CSP + SVM and FBCSP + SVM methods.

本文 CSP + SVM 和 FBCSP + SVM 方法的基本参数

| 经典方法 | 共同空间滤波器 | SVM 分类器 | |||||

| 选择个数 e | CSP 组数 | 滤波器维度 | 核函数 | 带宽 σ | 正则项 c | ||

| CSP + SVM | 4 | 1 | 32 | 径向基 | 0.5 | 0.25 | |

| FBCSP + SVM | 4 | 6 | 48 | 径向基 | 1.0 | 0.30 | |

表 4. The classification accuracy and Kappa coefficient for all participants by three decoding methods.

所有被试在 3 种方法下的识别率和 Kappa 系数

| 被试 | 识别方法 | |||||||

| CSP + SVM | FBCSP + SVM | TSCNN | ||||||

| 识别率 | Kappa 系数 | 识别率 | Kappa 系数 | 识别率 | Kappa 系数 | |||

| 1 | 74.50% | 0.660 | 78.85% | 0.718 | 86.50% | 0.820 | ||

| 2 | 55.28% | 0.404 | 60.42% | 0.472 | 74.08% | 0.654 | ||

| 3 | 80.10% | 0.735 | 80.50% | 0.740 | 92.75% | 0.903 | ||

| 4 | 53.65% | 0.382 | 57.48% | 0.433 | 70.50% | 0.607 | ||

| 5 | 50.08% | 0.334 | 56.04% | 0.414 | 66.60% | 0.555 | ||

| 6 | 48.82% | 0.318 | 45.72% | 0.276 | 62.25% | 0.497 | ||

| 7 | 75.40% | 0.672 | 80.60% | 0.741 | 88.24% | 0.843 | ||

| 8 | 78.36% | 0.712 | 80.80% | 0.744 | 87.09% | 0.828 | ||

| 9 | 80.75% | 0.743 | 81.45% | 0.753 | 92.80% | 0.904 | ||

| 均值 | 66.34% | 0.551 | 69.10% | 0.588 | 80.09% | 0.735 | ||

3.3. 混淆矩阵结果分析

为进一步分析所提方法对每类运动想象 EEG 识别效果的影响,我们计算出所有被试数据集在 3 种识别方法下的平均混淆矩阵。如图 3 所示,混淆矩阵的横轴代表识别方法预测的运动想象类别,纵轴代表实际的运动想象类别,对角线元素表示各运动想象类别被正确分类的比率,而非对角线元素表示各运动想象类别被错误分类的比率。从图 3a、3b 可以看出,CSP + SVM 和 FBCSP + SVM 方法在左手、右手及脚部运动想象 EEG 的识别率均小于 70%。尤其是对左右手运动想象的分类,CSP + SVM 的误分率分别达到 20.15% 和 22.20%,而 FBCSP + SVM 的误分率分别为 18.10% 和 19.85%,均高于其他两类的误分率。这可能是由于左右手运动想象占据相同的运动感觉区,导致 EEG 的空间分辨率较低,另外 CSP 和 FBCSP 提取的空间特征可分性有限,从而无法进一步提升 EEG 的识别率。本文所提 TSCNN 方法能够显著降低左右手运动想象 EEG 的误分率,而左右手的识别率分别提升至 80.26% 和 79.60%。这说明相比于 CSP + SVM 和 FBCSP + SVM 方法,TSCNN 方法不仅能够学习 EEG 的时间特征,还能进一步抽取 EEG 的空间特征,以提升左右手运动想象 EEG 的空间分辨率。另外,通过深度卷积计算,TSCNN 方法可以从原始 EEG 信号中自适应地学习可分性更强的时空特征,从而提升每个运动想象类别的识别率。

图 3.

The confusion matrix for motor imagery EEG classes by three decoding methods

三种解码方法下的运动想象脑电类别混淆矩阵

a. CSP + SVM;b. FBCSP + SVM;c. TSCNN

a. CSP + SVM; b. FBCSP + SVM; c. TSCNN

3.4. 其他方法与结果对比

为进一步验证所提 TSCNN 方法的有效性,在 BCI Competition IV-2a 公开数据集上还开展了一些其他基于深度学习方法的对比实验。这些基于深度学习方法的网络结构与参数均是根据文献中的设定而来。表 5 列出本文方法与经典的 CSP + SVM 和 FBCSP + SVM 方法以及其他深度学习方法的平均解码性能结果。从表 5 整体上可以看出,相比经典的 CSP + SVM 和 FBCSP + SVM 方法,基于深度学习的方法在识别率和 Kappa 系数上都有显著的提升。然而,在算法的两个运行时间指标上看,基于深度学习的方法均比经典方法耗时,尤其训练集运行时间是经典方法的 5 倍以上。这归因于深度学习方法在训练神经网络各层参数过程中需要花费大量时间。Schirrmeister 等[22]设计的深层(DeepCNN)和浅层(ShallowCNN)两种卷积神经网络结构由于卷积层没有充分考虑 EEG 信号的时域和空间域特性,在四类运动想象 EEG 公开数据集上测试的平均解码识别率仅为 70.10% 和 71.90%,Kappa 系数也比其他深度学习方法较低。虽然 Pérez-Zapata 等[19]以频域功率谱密度作为 EEG 信号的特征,结合设计的 9 层深度卷积神经网络(PSD + CNN),对四类运动想象 EEG 信号的平均解码精度能够达到 87.97%,但是由于其网络结构较为复杂、优化参数较多、计算量较大,导致算法的运行时间较长,不适合 EEG 信号的在线解码应用。本文所提 TSCNN 方法不仅能够获得较高的解码识别率和 Kappa 系数,同时在运行时间上均比其他基于深度学习的方法要低,尤其测试集运行时间(18.04 s)与经典的 FBCSP + SVM 方法(16.95 s)基本相当。这说明相较于其他深度学习网络模型,本文方法能够兼顾分类正确率和分类效率,更适合在线解码应用。

表 5. Comparison of decoding performance for different methods.

不同方法的解码性能对比

| 解码方法 | 解码性能(平均) | |||

| 识别率 | Kappa 系数 | 训练集运行时间/s | 测试集运行时间/s | |

| CSP + SVM | 66.34% | 0.551 | 25.60 | 10.38 |

| FBCSP + SVM | 69.10% | 0.588 | 48.25 | 16.95 |

| PSD + CNN[19] | 87.97% | 0.840 | 952.65 | 51.82 |

| C2CNN[20] | 74.46% | 0.659 | 206.04 | 25.60 |

| STFT + CNN[21] | 75.46% | 0.673 | 375.96 | 30.28 |

| ShallowCNN[22] | 71.90% | 0.625 | 607.20 | 50.50 |

| DeepCNN[22] | 70.10% | 0.601 | 1 025.68 | 52.66 |

| CNN + SAE[23] | 73.25% | 0.643 | 625.88 | 34.24 |

| TSCNN | 80.09% | 0.735 | 198.05 | 18.04 |

4. 讨论与结论

本研究主要通过依次设计时间和空间方向上的一维卷积层,从运动想象 EEG 信号中提取时域和空间域特征,并结合 2 层二维卷积结构对 EEG 的时空特征进行联合学习,最后利用全连接层和 Softmax 层实现对四类运动想象 EEG 信号的分类识别。如表 4 所示,本文所提 TSCNN 的平均解码精度(80.09%)和 Kappa 系数(0.735)均显著优于经典的 CSP + SVM 和 FBCSP + SVM 方法,整体识别率分别提高了 13.75% 和 10.99%。结合表 1 和表 2 所示可知,TSCNN 网络的解码性能受卷积层 1 的参数影响较大,从 EEG 信号提取的时域特征信息越多,TSCNN 网络的解码精度越高。此外,从图 3 结果来看,与 CSP + SVM 和 FBCSP + SVM 方法相比,TSCNN 显著降低了四类运动想象 EEG 的误分率,尤其对于左右手运动想象 EEG 的误分率均小于 10%。这说明,相比于 CSP 和 FBCSP 手工提取空间特征的方法,TSCNN 网络在抽取 EEG 信号空间特征上显示出一定的优越性。相比于其他基于深度学习的方法,本文所提 TSCNN 方法不仅能够学习运动想象 EEG 信号的时空特征,进而获得较高的解码精度和 Kappa 系数,而且由于设计的网络结构更为简单、优化参数较少,算法运行所需时间更短,训练的网络模型更加适合运动想象 EEG 的在线解码。

综上所述,本研究所提基于时空特征学习的卷积神经网络结构能够从 EEG 信号中抽取可分性更强的时空特征,进而提升运动想象 EEG 解码的准确性和可靠性,为基于运动想象的脑-机接口系统应用提供一种新的算法设计思路。目前本研究所设计的深度卷积神经网络结构只在 8 ~ 30 Hz 频带内抽取脑电的时空特征,下一步将尝试结合 EEG 的频域特征进一步设计基于时-频-空域特征学习的深度卷积神经网络,实现对运动想象 EEG 的时-频-空域特征联合学习,提升 EEG 信号的解码精度。同时,探索卷积层神经元输出的可视化方法,解释卷积神经网络学习的时域、频域及空间域特征,为优化网络结构和参数配置提供重要参考依据。

利益冲突声明:本文全体作者均声明不存在利益冲突。

Funding Statement

国家自然科学基金(61573340,61773369,U1813214);中国科学院前沿科学重点研究项目(QYZDY-SSW-JSC005);辽宁省“兴辽英才计划”项目(XLYC1908030)

References

- 1.Rohm M, Schneiders M, Müller C, et al Hybrid brain-computer interfaces and hybrid neuroprostheses for restoration of upper limb functions in individuals with high-level spinal cord injury. Artif Intell Med. 2013;59(2):133–142. doi: 10.1016/j.artmed.2013.07.004. [DOI] [PubMed] [Google Scholar]

- 2.López-Larraz E, Trincado-Alonso F, Rajasekaran V, et al Control of an ambulatory exoskeleton with a brain-machine interface for spinal cord injury gait rehabilitation. Front Neurosci. 2016;10:359. doi: 10.3389/fnins.2016.00359. [DOI] [PMC free article] [PubMed] [Google Scholar]

- 3.Meng J, Zhang S, Bekyo A, et al Noninvasive electroencephalogram based control of a robotic arm for reach and grasp tasks. Sci Rep. 2016;6:38565. doi: 10.1038/srep38565. [DOI] [PMC free article] [PubMed] [Google Scholar]

- 4.Doud A J, Lucas J P, Pisansky M T, et al Continuous three-dimensional control of a virtual helicopter using a motor imagery based brain-computer interface. PloS One. 2011;6(10):263–296. doi: 10.1371/journal.pone.0026322. [DOI] [PMC free article] [PubMed] [Google Scholar]

- 5.Chaudhary U, Birbaumer N, Ramos-Murguialday A Brain–computer interfaces for communication and rehabilitation. Nat Rev Neurol. 2016;12(9):513. doi: 10.1038/nrneurol.2016.113. [DOI] [PubMed] [Google Scholar]

- 6.Pfurtscheller G, Brunner C, Schlögl A, et al Mu rhythm (de) synchronization and EEG single-trial classification of different motor imagery tasks. NeuroImage. 2006;31(1):153–159. doi: 10.1016/j.neuroimage.2005.12.003. [DOI] [PubMed] [Google Scholar]

- 7.Kato K, Takahashi K, Mizuguchi N, et al Online detection of amplitude modulation of motor-related EEG desynchronization using a lock-in amplifier: Comparison with a fast Fourier transform, a continuous wavelet transform, and an autoregressive algorithm. J Neurosci Meth. 2018;293:289–298. doi: 10.1016/j.jneumeth.2017.10.015. [DOI] [PubMed] [Google Scholar]

- 8.Taran S, Bajaj V Motor imagery tasks-based EEG signals classification using tunable-Q wavelet transform. Neural Comput Appl. 2019;31:6925–6932. [Google Scholar]

- 9.Kevric J, Subasi A Comparison of signal decomposition methods in classification of EEG signals for motor-imagery BCI system. Biomed Signal Proces. 2017;31:398–406. [Google Scholar]

- 10.Lotte F, Guan C Regularizing common spatial patterns to improve BCI designs: unified theory and new algorithms. IEEE Trans Biomed Eng. 2010;58(2):355–362. doi: 10.1109/TBME.2010.2082539. [DOI] [PubMed] [Google Scholar]

- 11.Lotte F, Bougrain L, Cichocki A, et al A review of classification algorithms for EEG-based brain–computer interfaces: a 10 year update. J Neural Eng. 2018;15(3):031005. doi: 10.1088/1741-2552/aab2f2. [DOI] [PubMed] [Google Scholar]

- 12.Chu Yaqi, Zhao Xingang, Zou Yijun, et al Decoding multiclass motor imagery EEG from the same upper limb by combining Riemannian geometry features and partial least squares regression. J Neural Eng. 2020;17(4):046029. doi: 10.1088/1741-2552/aba7cd. [DOI] [PubMed] [Google Scholar]

- 13.Duan Lijuan, Bao Menghu, Cui Song, et al Motor imagery EEG classification based on kernel hierarchical extreme learning machine. Cogn Comput. 2017;9(6):758–765. [Google Scholar]

- 14.Shin H C, Roth H R, Gao M, et al Deep convolutional neural networks for computer-aided detection: CNN architectures, dataset characteristics and transfer learning. IEEE Trans Med Imaging. 2016;35(5):1285–1298. doi: 10.1109/TMI.2016.2528162. [DOI] [PMC free article] [PubMed] [Google Scholar]

- 15.Al-Ayyoub M, Nuseir A, Alsmearat K, et al Deep learning for Arabic NLP: A survey. J Comput Sci. 2018;26:522–531. [Google Scholar]

- 16.Garland J, Gregg D Low complexity multiply accumulate unit for weight-sharing convolutional neural networks. IEEE Comput Archit L. 2017;16(2):132–135. [Google Scholar]

- 17.Tang Z, Li C, Sun S Single-trial EEG classification of motor imagery using deep convolutional neural networks. Optik. 2017;130:11–18. [Google Scholar]

- 18.孔祥浩, 马琳, 薄洪健, 等 CNN 与 CSP 相结合的脑电特征提取与识别方法研究. 信号处理. 2018;34(2):164–173. [Google Scholar]

- 19.Pérez-Zapata A F, Cardona-Escobar A F, Jaramillo-Garzón J A, et al. Deep Convolutional Neural Networks and power spectral density features for Motor Imagery classification of EEG Signals// 2018 International Conference on Augmented Cognition. Cham: Springer, 2018: 158-169.

- 20.Sakhavi S, Guan C, Yan S Learning temporal information for brain-computer interface using convolutional neural networks. IEEE Trans Neur Net Lear. 2018;29(11):5619–5629. doi: 10.1109/TNNLS.2018.2789927. [DOI] [PubMed] [Google Scholar]

- 21.胡章芳, 张力, 黄丽嘉, 等 基于时频域的卷积神经网络运动想象脑电信号识别方法. 计算机应用. 2019;39(8):2480–2483. doi: 10.11772/j.issn.1001-9081.2018122553. [DOI] [Google Scholar]

- 22.Schirrmeister R T, Springenberg J T, Fiederer L D J, et al Deep learning with convolutional neural networks for EEG decoding and visualization. Hum Brain Mapp. 2017;38(11):5391–5420. doi: 10.1002/hbm.23730. [DOI] [PMC free article] [PubMed] [Google Scholar]

- 23.Tabar Y R, Halici U A novel deep learning approach for classification of EEG motor imagery signals. J Neural Eng. 2016;14(1):016003. doi: 10.1088/1741-2560/14/1/016003. [DOI] [PubMed] [Google Scholar]

- 24.Delorme A, Mullen T, Kothe C, et al EEGLAB, SIFT, NFT, BCILAB, and ERICA: new tools for advanced EEG processing. Comput Intel Neurosc. 2011;2011:10. doi: 10.1155/2011/130714. [DOI] [PMC free article] [PubMed] [Google Scholar]

- 25.Ang K K, Chin Z Y, Wang C, et al Filter bank common spatial pattern algorithm on BCI competition IV datasets 2a and 2b. Front Neurosci. 2012;6:39. doi: 10.3389/fnins.2012.00039. [DOI] [PMC free article] [PubMed] [Google Scholar]

- 26.Wu Wei, Chen Zhe, Gao Xiaorong, et al Probabilistic common spatial patterns for multichannel EEG analysis. IEEE Trans Pattern Anal. 2014;37(3):639–653. doi: 10.1109/TPAMI.2014.2330598. [DOI] [PMC free article] [PubMed] [Google Scholar]

- 27.Quitadamo L R, Cavrini F, Sbernini L, et al Support vector machines to detect physiological patterns for EEG and EMG-based human–computer interaction: a review. J Neural Eng. 2017;14(1):011001. doi: 10.1088/1741-2552/14/1/011001. [DOI] [PubMed] [Google Scholar]

- 28.LeCun Y, Bengio Y, Hinton G Deep learning. Nature. 2015;521(7553):436. doi: 10.1038/nature14539. [DOI] [PubMed] [Google Scholar]

- 29.Billinger M, Daly I, Kaiser V, et al. Is it significant? Guidelines for reporting BCI performance// 2012 Towards Practical Brain-Computer Interfaces. Berlin: Springer, 2012: 333-354.

- 30.Wright S J Coordinate descent algorithms. Math Program. 2015;151(1):3–34. [Google Scholar]