Abstract

由于儿童心脏大小随年龄变化显著,且儿童心率较快,超声心动图心脏边界相较成人更模糊,因此儿科超声心动图的准确分割是一项具有挑战性的任务。针对上述问题,本文提出了一种结合通道注意力和尺度注意力的双解码器网络模型。首先,利用结合深监督策略的注意力引导解码器,获取心室区域的注意力图;然后,将产生的心室注意力通过跳跃连接返回到网络的多个层,调整编码器生成的特征权重,突出左右心室区域;最后,通过尺度注意力模块和通道注意力模块强化左右心室边缘特征。实验结果表明,本文所提方法在所采集的双侧心室分割数据集中,平均戴斯系数(DSC)达到90.63%,优于医学图像分割领域一些常规和最新方法,尤其在心室边缘处分割更清晰。本文的研究可为儿科超声心动图双侧心室分割以及后续先天性心脏病辅助诊断提供新的解决方案。

Keywords: 儿科超声心动图, 双侧心室分割, 注意力机制, 深监督, 多尺度

Abstract

Accurate segmentation of pediatric echocardiograms is a challenging task, because significant heart-size changes with age and faster heart rate lead to more blurred boundaries on cardiac ultrasound images compared with adults. To address these problems, a dual decoder network model combining channel attention and scale attention is proposed in this paper. Firstly, an attention-guided decoder with deep supervision strategy is used to obtain attention maps for the ventricular regions. Then, the generated ventricular attention is fed back to multiple layers of the network through skip connections to adjust the feature weights generated by the encoder and highlight the left and right ventricular areas. Finally, a scale attention module and a channel attention module are utilized to enhance the edge features of the left and right ventricles. The experimental results demonstrate that the proposed method in this paper achieves an average Dice coefficient of 90.63% in acquired bilateral ventricular segmentation dataset, which is better than some conventional and state-of-the-art methods in the field of medical image segmentation. More importantly, the method has a more accurate effect in segmenting the edge of the ventricle. The results of this paper can provide a new solution for pediatric echocardiographic bilateral ventricular segmentation and subsequent auxiliary diagnosis of congenital heart disease.

Keywords: Pediatric echocardiography, Bilateral ventricular segmentation, Attention mechanism, Deep supervision, Multi scales

0. 引言

先天性心脏病(congenital heart disease,CHD)在全国多地均位居新生儿出生缺陷首位,也是心血管外科治疗患者数排行第二位的病种[1]。超声心动图仪是目前临床常规心脏检查中使用最广泛的心脏成像设备,对心血管疾病的诊断和评估起着至关重要的作用。临床评价指标,如心脏舒张期末期容积(end-diastolic volume,ED)、收缩期末期容积(end-systolic volume,ES)和射血分数(ejection fractions,EF)的计算十分重要,这些参数的获取需要对超声心动图中的心室进行准确分割。然而,要实现超声心动图心室的精确分割还存在诸多困难,如心肌和血池之间的对比度低、超声图像中含有的伪影,以及不同病患心脏结构的形状、质地和运动变异性等差异较大,均会影响最终的分割结果[2-3]。尤其对于婴幼儿等儿科患者来说,患者间心脏大小样本方差较大、心率较快,超声心动图心脏边界相较成人更加模糊[4],因此对儿科超声心动图进行分割更加困难。

根据已有文献显示,现有的超声心动图分割主要集中在左心室分割[5-9]。Carneiro等[5]提出了一种左心室心内膜跟踪方法,采用多个动态分割模型和深度学习方法实现了精确的左心室分割。Leclerc等[6]在超声心动图像分割任务中对比了常用的深度学习方法、结构化的随机森林方法以及B样条显性活动表面模型,发现基于U型网络(U-net)模型[7]的准确率和效率最高。Moradi等[8]结合特征金字塔和扩张卷积模型,利用解码器所有尺度的特征预测分割,得到了更准确的左心室内膜分割边缘。Leclerc等[9]提出一种多阶段的方法,包括用于定位的区域生成网络(region proposal network,RPN)和用于分割的U-net,有效提高了左心室分割的准确性。另一方面,随着心脏病学的发展,右心室的分割在提高心血管疾病诊断效率上扮演着越来越重要的角色,并且它可以为左心室的分割提供有价值的信息以作参考。然而,目前尚缺乏同时分割左右心室的方法,为此本文旨在探索一种实现左右心室同时分割的有效方法。

针对超声心动图边界模糊、分割困难等问题,现有方法大多采用级联网络,遵循由粗到细的分割策略[10-12]。例如,Bullock等[10]提出了X射线图像分割级联网络(X-Net)以加强边界分割。Du等[11]在级联网络中采用膨胀卷积和多层池化模块代替普通卷积,提取多尺度特征分割右心室。Leclerc等[12]设计了一种多级注意力网络,其一级分割网络生成心室和心肌部分的总体二值映射,所得结果和输入图像相乘作为二级分割网络输入,分别分割心室和心肌部分。该方法有效地减少了边界的错误分割,但整体精度没有明显提高。在上述使用级联策略的网络中,各个网络相对独立,训练过程困难,容易导致欠拟合,导致此类方法无法显著提高分割精度。针对这一问题,本文设计了一种双解码器的网络模型,产生心室区域注意力和最终分割结果,在粗分割和细分割任务中仅使用同一个编码器,在单个网络中实现了传统级联网络的两个步骤,缓解了欠拟合的问题。

受人类知觉和视觉认知的启发,Itti等[13]提出了注意力机制,它可以明显提高网络性能,并且已广泛用于突出感兴趣区域(region of interest,ROI)和抑制无关信息[14-16]。超声心脏图像中存在大量噪声,这可能导致分割精度降低,为此,在现有心脏图像分析中也大量使用注意力机制以强化心室区域[17-18]。Song等[17]设计了多尺度注意力机制和双边注意力模块提高心脏7个子结构区域的分割精度。Guo等[18]在超声心动图分割任务中提出了一个双路径特征提取模块(dual-path feature extraction module,DP-FEM),通过通道注意力机制强化判别性的特征。同时,他们还设计了基于空间注意力的高低特征融合模块(high-and-low-level feature fusion module,HL-FFM),将来自高层特征的丰富语义信息与低层特征的空间信息进行选择性融合。这些基于注意力的方法,有效改善了模型在心脏边界处的预测结果。受此启发,本文尝试在网络层面以及模块层面分别使用多种不同的注意力策略。具体而言,即在网络层面,通过注意力预测图,引导两个解码器。同时,针对注意力图生成过程中可能缺乏解释性的问题,引入深监督策略,以提升注意力引导的可解释性和有效性。在模块层面,本文针对小儿心脏大小随年龄增长变化显著以及心室边界模糊的特性,采用了尺度注意力模块(scale attention module,SAM)和通道注意力模块(channel attention module,CAM)以强化边缘并保留更多的上下文信息。

综上所述,本文提出了一种新的用于儿科超声心动图双侧心室分割的双解码器网络模型。该模型重点关注心室边缘分割精度的提升,以提高儿科CHD的诊断、预后和治疗的效率。主要创新包括:① 本研究设计了双解码器网络模型,将注意力引导解码器(attention-guided decoder,AGD)集成到网络的参数化跳跃连接中,用于生成空间注意力,进而改善编码器产生的特征图,从而加强心室区域的全局信息;再利用预测解码器对左右两心室区域细分;最终期望该模型能改善传统级联网络的欠拟合问题,有效提升心室和边缘的分割精度。② 在AGD中引入深监督策略,以期提升注意力引导的可解释性和有效性。③ 为了解决小儿心室大小随年龄增长变化显著、超声心动图心室边界模糊等客观因素所引起的心室边界分割不准确的问题,本文提出采用SAM为不同尺度特征图分配注意力权重,同时使用带有全局平均池化和全局最大池化的CAM加权重要特征通道,以求保留更多全局上下文信息。本研究期望实现双侧心室分割,同时有效提升心室分割网络模型的性能,使得需要借助精确分割结果来进行定量评估的心脏血流动力学参数更具有临床意义。

1. 注意力引导的双侧心室分割模型

本文设计的网络模型由AGD、参数化跳跃连接、带有CAM和SAM的预测解码器组成。网络模型的骨干网络采用强鲁棒性的U-net,具体表现为:在编码特征提取阶段,卷积层采用3 × 3卷积核,每一层输出的通道维数依次为64、128、256、512、512;X3、X4、X5为网络编码器第3、4、5层分别提取的特征图;在解码特征融合阶段,卷积层同样采用3×3卷积核,每一层输出的通道维数依次为512、256、128、64;同时在编码器和解码器之间采用含参数ai(i = 1, 2, ···, 5)的跳跃连接,详细结构如图1所示。

图 1.

Network structure diagram

网络结构图

网络模型的整个分割过程利用双解码器实现由粗到细的分割策略。AGD执行粗分割步骤,通过从编码器中提取语义丰富的特征,生成空间注意力图,从而指导后续的左右二心室分割任务。为了提高细分割性能,加速收敛,本文还在AGD中引入深监督,即利用输入图像的二值标签监督生成的注意力图。与目前基于注意力的医学图像分割方法在“黑箱”中产生注意力相比,AGD生成注意力的过程更具有可解释性。预测解码器部分包含4个CAM和1个SAM,执行细分割步骤。CAM用于细化网络中低层和高层拼接特征,使更多相关的通道被赋予更高的加权系数。最后,本文综合利用预测解码器产生的多尺度特征进行预测,采用SAM强化最相关尺度的特征,再经过输出通道为3的1×1卷积层和归一化指数函数柔性最大(softmax)层得到最终的分割结果。下面详细介绍模型的重点部分。

1.1. 结合深监督策略的AGD

在由粗到细的级联分割策略中,分割的第一步是粗分割,以期找到输入图像中的ROI。本文提出了一个AGD执行粗分割。具体而言,即AGD生成与ROI相关的注意力图,再通过参数化的跳跃连接将注意力图集成到网络中以细化特征表示,进而提高左右二心室分割性能。

AGD的基本网络结构是基于全卷积网络(fully convolutional networks,FCN)的特征融合模块,如图2所示。为了减少参数和硬件占用,从编码器中最后三层中提取语义丰富的特征图送到AGD中。首先对低空间分辨率的特征图进行双线性插值;再将上采样后的特征图进行通道压缩,压缩可以抑制通道间不相关信息;然后将压缩后的特征和上层的高空间分辨率的特征图进行相加,实现特征融合;最后,将三个特征图进行融合,得到最终目标区域(左右心室)的空间注意力映射图。

图 2.

Network structure of AGD

AGD网络结构图

AGD的计算过程如下:Xi∈RC×H×W,i∈(3, 4, 5)为网络编码器第3、4、5层分别提取的特征图。特征压缩和特征融合如式(1)~式(2)所示:

|

1 |

|

2 |

其中, F4表示融合了X4和X5的融合特征,F3表示融合了X3和F4的融合特征,WC5和WC4分别表示相对应的通道压缩卷积,作用是将下层经过线性插值后的特征图通道压缩至和上层通道数一致;W4表示用于融合X4和X5的特征融合卷积; 表示上下两层的特征图逐像素相加;T表示转置符号。最终,AGD的输出Y计算如式(3)所示:

表示上下两层的特征图逐像素相加;T表示转置符号。最终,AGD的输出Y计算如式(3)所示:

|

3 |

其中,W3表示用于融合X3和F4的特征融合卷积;WOUT表示输出卷积,输出通道为1; 表示S型激活函数(sigmoid)。

表示S型激活函数(sigmoid)。

传统的计算机视觉中注意力机制自动生成注意力图,但生成过程通常难以解释[19]。为此,本文在AGD中引入深监督策略。在遵循从粗到细的分割策略中,首先生成一个二值标签yb,其中前景为整个左右两心室部分,背景为超声心动图中除心室以外其他所有部分。yb计算如式(4)所示:

|

4 |

其中, yl和yr分别代表左、右心室的二值标签,然后利用二值损失函数Lb计算yb与注意力图Y之间的二值损失l,其中Lb由交叉熵损失LC和戴斯损失LD组合而成,如式(5)~式(6)所示:

|

5 |

|

6 |

此二值损失l用于指导AGD中的参数更新。通过引入深监督,注意力图Y由输入图像的二值标签yb监督。这样,先完成了左右二心室分割任务的分解任务,即首先提取整个心室区域,然后再将心室区域细分成左心室和右心室部分。这样的任务分解遵循了由粗到细的分割策略,降低了同时分割左右心室的难度。与传统的注意力机制相比,本文方法的注意力图的产生更具说服力和可解释性。

1.2. 带有参数的跳跃连接

为了矫正编码器产生的特征图,本文将AGD生成的注意力图集成到网络编码器和预测解码器的跳跃连接中。在跳跃连接中,还引入额外的残差路径恢复原始特征图的信息,进一步提高分割性能。与传统残差连接相比,残差路径中αi, i∈(1, 2, 3, 4, 5)代表网络的可学习参数,在网络反向传播过程中更新,如图1所示。经过矫正后的特征图FZi, i∈(1, 2, 3, 4, 5)计算如式(7)所示:

|

7 |

其中,Fi, i∈(1, 2, 3, 4, 5)代表编码器产生的原始特征图,Yi, i∈(1, 2, 3, 4, 5)代表AGD产生的空间注意力图Y经过尺寸调整后的结果,矫正后的特征图FZi被送到预测解码器中进行左右心室的分割预测。带有参数的跳跃连接可以增加网络的非线性能力,帮助网络找出每条残差路径中最优参数,从而提高跳跃连接的有效性。

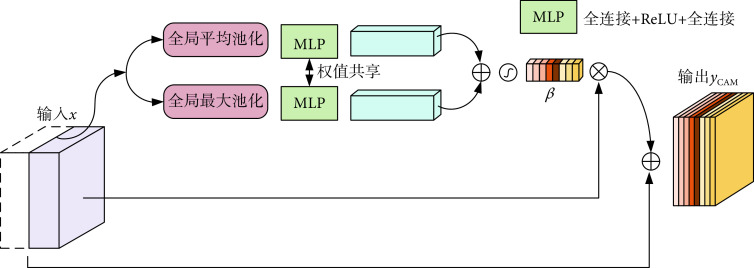

1.3. CAM

编码器产生的低级特征和AGD生成的注意力图相乘,实现空间注意力矫正。然后,经过空间注意力矫正的低级特征和预测解码器输出的高级特征进行通道拼接,如图1所示。由于特征语义级别不同,跳跃连接的两个输入对于分割任务有不同的重要性。其中来自编码器的特征通道主要包含低级信息,包括边缘、纹理等底层特征,用于捕捉图像的细节和局部结构;而来自预测解码器的特征通道包含更多语义信息,用于描述全局结构和语义分割等高级特征。因此,为了更好地挖掘最有用的特征通道,引入了通道注意力机制,自动突出相关的特征通道,同时抑制不相关的通道。本文所提出的CAM的细节如图3所示。

图 3.

Network structure of CAM

CAM网络结构

输入x表示通道拼接之后的特征图,首先使用全局平均池化和全局最大池化获取每个通道的全局信息,输出分别表示为Pavg(x)和Pmax(x)。多层感知机(multilayer perceptron,MLP)用于获得通道注意力系数β,MLP由两个全连接层实现,其中第一层的输出通道为C/r,然后经过线性整流函数(rectified liner units,ReLU),第二层的输出通道为C,设置r = 2获得性能和计算成本的平衡。对于Pavg(x)和Pmax(x)使用的MLP是权值共享的,它们的结果相加再经过sigmoid得到β。CAM的输出yCAM通过残差连接实现,如式(8)所示:

|

8 |

1.4. SAM

在皮肤病分割任务中,对于不同大小的皮肤病变,不同尺度的特征图与其具有不同的相关性,SAM能够自动确定每个像素的尺度权重,以便网络能够自适应不同大小的分割目标[20]。类似地,在儿科心动图心室分割任务中,小儿心室部分差异过大,给儿童心室分割带来了挑战。因此,为了更好地强化心室多尺度的边缘细节,提升分割精度,本文采用了皮肤病分割任务中的SAM。该模块被放置于网络末端,如图1所示。

SAM的网络结构图如图4所示,首先使用双线性插值将解码器得到的不同尺度下的特征图Si, i∈(1, 2, 3, 4)重新采样原始图像大小。为了降低计算成本,利用1 × 1卷积将这些特征图压缩为4个通道,并将不同尺度的压缩结果拼接成混合特征图  作为SAM的输入。与CAM相类似,将全局平均池化和全局最大池化与共享权值的MLP结合,以获得每个通道的系数。由于这里的输入

作为SAM的输入。与CAM相类似,将全局平均池化和全局最大池化与共享权值的MLP结合,以获得每个通道的系数。由于这里的输入  融合了解码器不同尺度的特征图,所以这里的通道系数就是不同尺度下的特征图与分割对象具有的相关性,即尺度注意力系数。尺度注意力系数向量记为

融合了解码器不同尺度的特征图,所以这里的通道系数就是不同尺度下的特征图与分割对象具有的相关性,即尺度注意力系数。尺度注意力系数向量记为  。为了在每个像素上分布多尺度注意力权重,本文额外使用空间注意力模块(spatial attention module,LA*),以

。为了在每个像素上分布多尺度注意力权重,本文额外使用空间注意力模块(spatial attention module,LA*),以  作为输入,生成空间级注意力系数

作为输入,生成空间级注意力系数  ,因此

,因此  就表示每个尺度的像素级注意力。LA*由一个3 × 3和一个1 × 1的卷积层组成,它们输出通道均为4。SAM也使用了残差连接进行训练,其输出ySAM的计算过程如式(9)所示:

就表示每个尺度的像素级注意力。LA*由一个3 × 3和一个1 × 1的卷积层组成,它们输出通道均为4。SAM也使用了残差连接进行训练,其输出ySAM的计算过程如式(9)所示:

图 4.

Network structure of SAM

SAM网络结构

|

9 |

由于网络预测解码器会产生不同尺度的特征图,SAM可以帮助网络找到其中对分割结果作用最有效的尺度的特征图,并给与它更大的权重,有效地保留了图像边缘信息。

2. 实验和结果分析

为了验证AGD对于最后分割结果的效果,本文在编码器产生的不同尺度特征图组合下依次进行了实验对比。此外,为了验证SAM对于分割效果的有效性,选择解码器不同尺度特征图组合进行分割预测,选择效果最优的组合。最后,为了验证算法的优越性,将所提出方法与经典算法以及最新的医学图像分割方法做了对比实验,并给出实验分析。

2.1. 实验数据

本文使用的数据由上海儿童医学中心采集。原始数据包含65个三维(three dimensional,3D)儿童超声心动图视频序列。这些数据来自飞利浦超声诊断仪(iE33,Philips,美国),儿童患者年龄从0~2岁不等。所有数据均获得患者监护人的知情同意,并且通过了上海交通大学医学院附属上海儿童医学中心的本地伦理审查委员会的批准(批文编号:SCMCIRB-Y2020056)。经过预处理和标注,生成了包括2 280张含完整左右心室的二维(two dimensional,2D)儿科超声心动图像及对应的标签,然后按照3:1:1的比例依次划分为训练集、验证集和测试集。由于网络中AGD需要二值标签进行监督,所以本文还对标签额外进行了二值处理。

2.2. 实验环境及设置

实验环境为:操作系统Windows(10 64位,Microsoft,美国);显卡RTX 2060 SUPER(Nvidia,美国),编译集成环境PyCharm 2021(JetBrains,捷克),最大迭代轮数设为400。本文选择适应性矩估计(adaptive moment estimation,Adam)作为优化器进行训练,批大小设置为8,权重衰减为10−5,采用动态学习率,初始学习率设置为10−2,其更新过程如式(10)所示:

|

10 |

其中,lr表示当前学习率,lr0表示初始学习率,e是当前迭代轮数,Ne为总迭代轮数,kmin为初始学习率乘上的最小比例,设置kmin = 10−2。

2.3. 评估指标

本文主要针对左、右心室两个区域的分割精度进行评价。分别以戴斯相似系数(Dice similarity coefficient,DSC)、左右心室分割的精确率(precision)和召回率(recall)评估预测分割结果。其中,DSC用于度量两个集合的相似度,计算如式(11)所示:

|

11 |

其中,Ra和Rb分别表示算法分割的区域和标签,真阳性(true positive,TP)表示预测为正样本,实际为正样本;假阳性(false positive,FP)表示预测为正样本,实际为负样本;假阴性(false negative,FN)表示预测为负样本,实际为正样本。

precision和recall的定义如式(12)、式(13)所示:

|

12 |

|

13 |

为了给出更加清晰的定量分析,分别计算出左心室分割的precision(left ventricular precision,L-pre)、左心室分割的recall(left ventricular recall,L-recall)、右心室分割的precision(right ventricular precision,R-pre)和右心室分割的recall(right ventricular recall,R-recall)。

2.4. 消融实验

2.4.1. AGD对分割结果的影响

AGD输出的注意力图会返回到网络中,通过跳跃连接引导特征图更加关注ROI区域。因此,本文首先研究AGD特征融合过程和其输出返回到网络跳跃连接中位置(连接层)的影响。结果如表1所示,加粗字体表示每列最优值,下划线表示次优值。

表 1. Quantitative evaluation of the effect of attention map on different variants of multi-layer network encoders.

注意力图作用在网络编码器多层次不同变体的定量评价

| 网络结构 | DSC | L-pre | R-pre | L-recall | R-recall |

| U-net | 87.54% | 83.24% | 80.41% | 84.91% | 84.04% |

| AGD(1) | 89.31% | 83.47% | 81.19% | 85.98% | 85.25% |

| AGD(1~2) | 89.36% | 86.99% | 82.13% | 82.77% | 85.13% |

| AGD(1~3) | 89.46% | 85.59% | 82.35% | 83.88% | 84.63% |

| AGD(1~4) | 89.60% | 87.34% | 85.75% | 84.15% | 82.63% |

| AGD(1~5, X3 + X4) | 88.51% | 83.18% | 79.33% | 82.94% | 83.62% |

| AGD(1~5, X4 + X5) | 89.43% | 85.64% | 81.72% | 84.39% | 84.58% |

| AGD(1~5) (本文) | 89.97% | 87.17% | 82.84% | 86.54% | 86.48% |

这里U-net表示仅使用基本骨架U-net进行训练,AGD(1~k),(k = 2, 3, 4, 5)表示AGD融合了编码器第3、4、5层特征图特征的基础上,输出作用于网络编码器第1~k层。如表1所示,AGD的引入会在U-net基础上提升网络的分割性能,当注意力图引导网络编码器的特征层数升高时,网络的分割性能也会有所提升。当注意力图作用于网络编码器第1~5层时得到分割定量结果的最佳值,DSC达到了89.97%,L-recall和R-recall也均是最优值。为了验证AGD内部特征融合部分对网络的影响,在注意力图作用于编码器第1~5层的基础上,本文将编码器不同层的特征图组合作为AGD的输入进行实验。AGD(1~5, X3 + X4)表示将编码器第3、4层特征图组合作为AGD的输入进行特征融合,AGD(1~5, X4 + X5)表示将编码器第4、5层特征图组合作为输入进行特征融合。如表1所示,虽然不同组合的特征图作为AGD的输入和U-net相比,会有效提升网络性能,但是,当把编码器第3、4、5层特征图进行融合能达到最佳的效果。

2.4.2. SAM对分割结果的影响

为了研究不同尺度特征图的组合对左右二心室分割的影响,本文将解码器不同尺度的特征图进行拼接作为SAM的输入进行消融实验。SAM(1~k)(k = 2, 3, 4, 5)表示将解码器第1~k层的特征图进行拼接。

定量比较结果如表2所示,加粗字体表示每列最优值,下划线表示次优值。本研究发现,多个尺度的特征组合优于只使用U-net的情况。将尺度 1~4的特征进行拼接时,DSC获得了89.44%的最佳值。然而,当把5个尺度的特征全部结合起来时,DSC有了大幅度的下降。这表明最低分辨率水平的特征图不适合进行像素级的预测。因此,在网络中只融合了尺度1~4的特征。

表 2. Quantitative evaluation of ventricular segmentation by attention methods at different scales.

不同尺度注意力方法对心室分割的定量评价

| 网络结构 | DSC | L-pre | R-pre | L-recall | R-recall |

| U-net | 87.54% | 83.24% | 80.41% | 84.91% | 84.04% |

| SAM (1~2) | 88.74% | 82.28% | 78.64% | 85.21% | 86.90% |

| SAM (1~3) | 89.18% | 84.19% | 80.16% | 86.07% | 85.54% |

| SAM (1~4) | 89.44% | 83.05% | 81.06% | 86.47% | 85.85% |

| SAM (1~5) | 88.83% | 85.52% | 80.16% | 82.48% | 84.76% |

2.5. 各类分割算法分割左右心室效果的对比

在这项工作中,本文将所提出的方法与7种医学图像分割领域的网络进行了对比,其中注意力U-net(attention U-net)[21]、嵌套U-net(U-net++)[22]和深度研究实验室v3+网络(Deeplabv3+)[23]是医学图像分割领域的经典网络;先验注意力网络(prior attention network,PAnet)、改进U-net(refining U-net,RU-net)和残差空洞U-net(residual dilation U-net,ResDUnet)[24]是超声图像分割领域最新的方法,有效性在左心室内外边界(心内膜和心外膜)分割和左心室分割任务中均得到了验证。本文将这7种方法与提出的方法均在自采集的数据集上进行了实验。

不同算法在左右二心室分割验证集上的定量结果如表3所示,加粗字体表示每列最优值,下划线表示次优值,可以看出所有的分割算法在DSC上都有很好的表现,本文的方法获得了90.63%的DSC,比U-net的87.54%提高了3.09%。虽然在L-pre和R-pre得分上,本文的方法略低于ResDUnet,但是,在recall得分上,本文的方法又取得了所有分割算法中最优结果。其中,L-recall为87.90%,R-recall为86.29%,主要是因为AGD生成的注意力映射可以细化编码器产生的特征图,帮助模型更准确地检测到心室区域,实现粗分割,在最终的细化分割中引入了SAM,结合了解码器不同尺度的特征,对左右心室区域进行更精细的预测,因此recall更高。

表 3. Comparison of the segmentation effects of various algorithms on the left and right ventricle segmentation verification set.

各类算法在左右二心室分割验证集上的分割效果对比表

| 分割算法 | DSC | L-pre | R-pre | L-recall | R-recall |

| U-net | 87.54% | 83.24% | 80.41% | 84.91% | 84.04% |

| attention U-net | 89.40% | 83.82% | 82.47% | 85.32% | 84.15% |

| U-net++ | 89.44% | 85.81% | 80.14% | 82.76% | 85.94% |

| Deeplabv3+ | 88.99% | 84.71% | 77.57% | 85.26% | 84.91% |

| PAnet | 87.60% | 87.47% | 82.90% | 80.07% | 83.22% |

| RU-net | 89.34% | 85.83% | 83.80% | 83.98% | 83.56% |

| ResDUnet | 89.46% | 88.05% | 84.96% | 83.98% | 83.40% |

| 本文 | 90.63% | 87.74% | 84.31% | 87.90% | 86.29% |

不同分割算法的分割结果可视化如图5所示,原始图像1边缘轮廓清晰;原始图像2亮度不均匀且存在伪影,红线框突出了一些错误的分割区域。可以看到其他算法会出现错误分割的问题,如attention U-net会将背景预测为心室,U-net++会把右心室错误预测为左心室。对比而言,本文的算法分割结果和标签吻合度最高。

图 5.

Visualization of the segmentation results of various algorithms on the left and right ventricle segmentation validation set

各类算法在左右二心室分割验证集上的分割结果可视化

分割结果边缘的可视化如图6所示,图6中本文方法与DSC得分较高的其他三个方法进行了比较,第1、2行分别为右心室和左心室分割的边缘可视化,图6中红色箭头突出了一些分割不准确的边界。可以看出:和其他的方法相比,无论是在左右心室中间心肌部分,还是在左心室的前侧壁部分,本文方法分割的边界和标签边界重合度最高。同时,在右心室边界的分割上也能达到很高的精度,这是因为本文采用了CAM与SAM,使网络更加关注对提升分割精确度更重要的相关特征通道与尺度特征。因此分割结果更准确,边界部分丢失的预测区域也更少。

图 6.

Comparison of segmentation edge visualization

分割边缘可视化对比图

3. 结论

本文提出了一种基于儿科超声心动图心室分割的双解码器模型,遵循了由粗到细的分割策略,实现了儿童超声心动图的双侧心室高精度分割。其中,由AGD生成的注意力图引导编码器关注分割对象,增强了模型的鲁棒性。AGD结合深监督使注意力的产生更具有可解释性。同时,本文还通过CAM与SAM,将多通道、多尺度特征融合,提升了分割效果。本文提出的分割模型比经典U-net以及一些最新的医学图像分割网络具有更高的分割精度,能够同时分割左右心室并且提升了心室边缘分割的准确性,可以为临床诊断提供有力的参考依据。本课题组今后的研究拟增加心脏超声图数据,例如其他成像角度的数据,并将2D分割任务拓展到3D分割任务。

重要声明

利益冲突声明:本文全体作者均声明不存在利益冲突。

作者贡献声明:庞俊主要负责模型搭建、实验设计、算法实现和论文撰写。王永雄主要负责提供实验指导和论文审阅修订。陈丽君、刘金龙负责儿科超声心动数据采集和标注。张佳鹏和裴刚负责数据的记录和分析。

伦理声明:本研究通过了上海交通大学医学院附属上海儿童医学中心机构伦理委员会的审批(批文编号:SCMCIRB-Y2020056)。

Funding Statement

国家自然科学基金资助项目(81970439,82001835);上海市自然科学基金资助项目(22ZR1443700)

National Natural Science Foundation of China; Natural Science Foundation of Shanghai

References

- 1.中国心血管健康与疾病报告编写组 中国心血管健康与疾病报告2021概要. 中国循环杂志. 2022;37(6):553–578. doi: 10.3969/j.issn.1000-3614.2022.06.001. [DOI] [Google Scholar]

- 2.Painchaud N, Skandarani Y, Judge T, et al Cardiac segmentation with strong anatomical guarantees. IEEE Transactions on Medical Imaging. 2020;39(11):3703–3713. doi: 10.1109/TMI.2020.3003240. [DOI] [PubMed] [Google Scholar]

- 3.Zhang J P, Wang Y X, Chen L J, et al. Dual-branch TransV-Net for 3D echocardiography segmentation. IEEE Transactions on Industrial Informatics, 2023, DOI: 10.1109/TII.2023.3249904.

- 4.Gahungu N, Trueick R, Bhat S, et al Current challenges and recent updates in artificial intelligence and echocardiography. Current Cardiovascular Imaging Reports. 2020;13:5. doi: 10.1007/s12410-020-9529-x. [DOI] [Google Scholar]

- 5.Carneiro G, Nascimento J C Combining multiple dynamic models and deep learning architectures for tracking the left ventricle endocardium in ultrasound data. IEEE Transactions on Pattern Analysis and Machine Intelligence. 2013;35(11):2592–2607. doi: 10.1109/TPAMI.2013.96. [DOI] [PubMed] [Google Scholar]

- 6.Leclerc S, Smistad E, Pedrosa J, et al Deep learning for segmentation using an open large-scale dataset in 2D echocardiography. IEEE Transactions on Medical Imaging. 2019;38(9):2198–2210. doi: 10.1109/TMI.2019.2900516. [DOI] [PubMed] [Google Scholar]

- 7.Ronneberger O, Fischer P, Brox T. U-net: convolutional networks for biomedical image segmentation//International Conference on Medical Image Computing and Computer-Assisted Intervention. Cham: Springer, 2015: 234-241.

- 8.Moradi S, Oghli M G, Alizadehasl A, et al MFP-Unet: a novel deep learning based approach for left ventricle segmentation in echocardiography. Physica Medica. 2019;67:58–69. doi: 10.1016/j.ejmp.2019.10.001. [DOI] [PubMed] [Google Scholar]

- 9.Leclerc S, Smistad E, Østvik A, et al LU-Net: a multistage attention network to improve the robustness of segmentation of left ventricular structures in 2-D echocardiography. IEEE Transactions on Ultrasonics, Ferroelectrics, and Frequency Control. 2020;67(12):2519–2530. doi: 10.1109/TUFFC.2020.3003403. [DOI] [PubMed] [Google Scholar]

- 10.Bullock J, Cuesta-Lázaro C, Quera-Bofarull A. XNet: a convolutional neural network (CNN) implementation for medical x-ray image segmentation suitable for small datasets//Medical Imaging 2019: Biomedical Applications in Molecular, Structural, and Functional Imaging. SPIE, 2019. DOI: 10.1117/12.2512451.

- 11.Du X, Xu X, Liu H, et al TSU-net: two-stage multi-scale cascade and multi-field fusion U-net for right ventricular segmentation. Computerized Medical Imaging and Graphics. 2021;93:101971. doi: 10.1016/j.compmedimag.2021.101971. [DOI] [PubMed] [Google Scholar]

- 12.Leclerc S, Smistad E, Grenier T, et al. RU-Net: a refining segmentation network for 2D echocardiography//2019 IEEE International Ultrasonics Symposium (IUS). Glasgow: IEEE, 2019: 1160-1163.

- 13.Itti L, Koch C, Niebur E A model of saliency-based visual attention for rapid scene analysis. IEEE Transactions on Pattern Analysis and Machine Intelligence. 1998;20(11):1254–1259. doi: 10.1109/34.730558. [DOI] [Google Scholar]

- 14.姚庆安,张鑫,刘力鸣,等 融合注意力机制和多尺度特征的图像语义分割. 吉林大学学报(理学版) 2022;60(6):1383–1390. doi: 10.13413/j.cnki.jdxblxb.2021405. [DOI] [Google Scholar]

- 15.Hu J, Shen L, Sun G, et al Squeeze-and-excitation networks. IEEE Transactions on Pattern Analysis and Machine Intelligence. 2020;42(8):2011–2023. doi: 10.1109/TPAMI.2019.2913372. [DOI] [PubMed] [Google Scholar]

- 16.Woo S, Park J, Lee J Y, et al. CBAM: convolutional block attention module// Proceedings of the European conference on computer vision (ECCV). 2018: 3-19. DOI: 10.1007/978-3-030-01234-2_1.

- 17.Song Y, Du X, Zhang Y, et al Two-stage segmentation network with feature aggregation and multi-level attention mechanism for multi-modality heart images. Computerized Medical Imaging and Graphics. 2022;97:102054. doi: 10.1016/j.compmedimag.2022.102054. [DOI] [PubMed] [Google Scholar]

- 18.Guo L, Lei B, Chen W, et al Dual attention enhancement feature fusion network for segmentation and quantitative analysis of paediatric echocardiography. Medical Image Analysis. 2021;71:102042. doi: 10.1016/j.media.2021.102042. [DOI] [PubMed] [Google Scholar]

- 19.Zhao X, Zhang P, Song F, et al Prior attention network for multi-lesion segmentation in medical images. IEEE Transactions on Medical Imaging. 2022;41(12):3812–3823. doi: 10.1109/TMI.2022.3197180. [DOI] [PubMed] [Google Scholar]

- 20.Gu R, Wang G, Song T, et al CA-Net: Comprehensive attention convolutional neural networks for explainable medical image segmentation. IEEE Transactions on Medical Imaging. 2021;40(2):699–711. doi: 10.1109/TMI.2020.3035253. [DOI] [PMC free article] [PubMed] [Google Scholar]

- 21.Oktay O, Schlemper J, Folgoc L L, et al. Attention U-net: learning where to look for the pancreas//International Conference on Medical Image Computing and Computer-assisted Intervention. Cham: Springer, 2018: 369-377.

- 22.Zhou Z, Rahman Siddiquee M M, Tajbakhsh N, et al. UNet++: a nested U-Net architecture for medical image segmentation//Deep Learning in Medical Image Analysis and Multimodal Learning for Clinical Decision Support (DLMIA 2018), Cham: Springer, 2018, 11045: 3-11.

- 23.Chen L C, Zhu Y, Papandreou G, et al. Encoder-decoder with atrous separable convolution for semantic image segmentation//Proceedings of the European conference on computer vision (ECCV). 2018: 801-818.

- 24.Amer A, Ye X, Janan F ResDUnet: a deep learning-based left ventricle segmentation method for echocardiography. IEEE Access. 2021;9:159755–159763. doi: 10.1109/ACCESS.2021.3122256. [DOI] [Google Scholar]