Abstract

目的

旨在探究孤独症谱系障碍(autism spectrum disorder, ASD)和正常发育(typically developing, TD)儿童在观看不同意图场景视频时的视觉感知差异,并通过机器学习算法,探索客观区分ASD和TD儿童的可行性。

方法

共纳入58名ASD儿童和50名TD儿童,观看包含联合意图和非联合意图的视频,使用儿童观看视频时在不同注视兴趣区的注视时长占比和注视次数占比作为原始特征指标,输入到分类器中构建分类模型,分析比较不同分类模型的分类准确率、灵敏度和特异度等指标。

结果

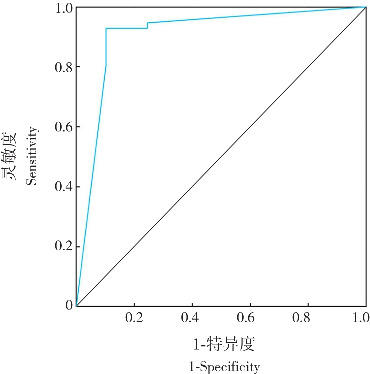

使用支持向量机、线性判别算法、决策树、随机森林和邻近算法(K=1、3、5、7)8种常见的分类器基于原始特征指标进行分类时,最高分类精度为81.90%。为进一步提高分类精度,采用特征重构方式,运用决策树分类器进行分类,分类模型的准确度高达91.43%,特异度为89.80%,灵敏度为92.86%,受试者操作特征曲线的曲线下面积为0.909(P<0.001)。

结论

采用眼动追踪数据构建的机器学习模型可精确地将ASD儿童与TD儿童区分开来,为开发快速客观筛查ASD的辅助工具提供科学依据。

Keywords: 孤独症谱系障碍, 机器学习, 联合意图, 动作理解, 眼动追踪, 儿童

Abstract

Objective

To investigate the differences in visual perception between children with autism spectrum disorder (ASD) and typically developing (TD) children when watching different intention videos, and to explore the feasibility of machine learning algorithms in objectively distinguishing between ASD children and TD children.

Methods

A total of 58 children with ASD and 50 TD children were enrolled and were asked to watch the videos containing joint intention and non-joint intention, and the gaze duration and frequency in different areas of interest were used as original indicators to construct classifier-based models. The models were evaluated in terms of the indicators such as accuracy, sensitivity, and specificity.

Results

When using eight common classifiers, including support vector machine, linear discriminant analysis, decision tree, random forest, and K-nearest neighbors (with K values of 1, 3, 5, and 7), based on the original feature indicators, the highest classification accuracy achieved was 81.90%. A feature reconstruction approach with a decision tree classifier was used to further improve the accuracy of classification, and then the model showed the accuracy of 91.43%, the specificity of 89.80%, and the sensitivity of 92.86%, with an area under the receiver operating characteristic curve of 0.909 (P<0.001).

Conclusions

The machine learning model based on eye-tracking data can accurately distinguish ASD children from TD children, which provides a scientific basis for developing rapid and objective ASD screening tools.

Keywords: Autism spectrum disorder, Machine learning, Joint intention, Action understanding, Eye tracking, Child

孤独症谱系障碍(autism spectrum disorder, ASD)是一种严重的神经发育障碍,其核心症状为社会互动与交流的缺损,以及重复的、局限的行为或兴趣[1-3]。ASD多起病于幼儿期,早期干预治疗能够有效改善预后,降低患儿成年期的疾病负担[4]。目前,ASD诊断主要依赖外在的行为学观察与评估人员的主观经验判断,由于缺乏相对客观的标准用于ASD的诊断和评估,导致了较高水平的漏诊和误诊风险[5-7]。因此,如何利用现代技术提高ASD早期诊断的客观性和准确性,开发快速筛查的辅助诊断方法,提高诊断效率,成了一个迫切需要解决的问题。

在日常生活中,涉及大量人际合作行为,如共同抬一张桌子、共同搭积木等。在这些合作行动中,相互协调依赖于对合作意愿的表达、对他人行动的预测,以及相应的个体行为的执行能力[8-9]。大量研究显示,12月龄左右的婴儿已经具备判断他人意图、预测他人行为及参与互动的能力[9-13];14月龄的婴儿可以理解合作场景和共同目标[14];2岁左右的儿童即便置身于尚未接触的游戏环境,亦能迅速掌握与同伴互动的技巧,与他人协作完成一系列简单任务[15]。

由于ASD儿童共同意愿不足,表现出非典型的合作行为[8,16-17]。Fitzpatrick等[16]发现ASD儿童在互动过程中难以完成大小和节奏一致的动作。ASD儿童的社会和非社会性缺陷对完成不同类型的合作任务影响程度不同[18-20]。Liebal等[21]对ASD儿童参与合作行为的意愿程度进行研究,发现ASD症状越强,越难理解合作游戏的目的。

注视模式是衡量联合意图(joint intention, JI)能力的重要行为指标之一。ASD儿童对人脸的不典型注视行为已被研究证实[22]。Frazier等[18]通过对ASD患者观看社会性/非社会性信息的眼动追踪研究进行荟萃分析,发现随着ASD患者年龄增长,在社交互动过程中,异常注视会加剧。然而上述研究[18,22]鲜有涉及比较JI和非联合意图(non-joint intention, NJI)两种模式下ASD儿童的注视模式。

眼动追踪技术因具有非侵入、无接触地捕捉人眼注视行为指标的优点而被广泛应用于研究ASD儿童的社交注视模式[23-25]。眼动技术与自由观看范式结合,可以测量被试对复杂社会情境的自发反应[24-28]。近年来,机器学习(machine learning, ML)逐渐被应用于基于眼动追踪数据的ASD诊断、分型、鉴别等方面[29-33]。

鉴于以上分析,本研究拟采用包含JI和NJI的社交视频作为试验刺激材料[13],探讨ASD儿童在观看不同类型社交视频时的眼动注视模式,通过对眼动数据的特征提取,运用ML算法进行分类,并根据分类模型的准确性和可靠性进行综合评价,以期构建一种能够客观区分ASD的模型,为辅助诊断提供科学指导。

1. 资料与方法

1.1. 研究对象

本研究共从北京、青岛、广州和深圳等专业机构招募了58名ASD儿童,所有参与儿童均符合《精神障碍诊断与统计手册(第5版)》中ASD诊断标准[34],由专业的儿童精神科医生确诊。选择50名来自北京一所幼儿园的正常发育(typically developing, TD)儿童为对照。两组儿童性别、年龄比较差异无统计学意义(P>0.05)。采用瑞文标准推理测验[35]对ASD组和TD组儿童的智力年龄进行匹配。在研究开展前,已获得儿童父母的书面知情同意,并获得儿童的口头同意。本研究经中国科学院心理学研究所伦理委员会批准(H19053)。

表1.

ASD组和TD组的人口统计学信息比较

| 组别 | 例数 | 性别(男/女, 例) | 年龄( , 岁) |

|---|---|---|---|

| TD组 | 50 | 41/9 | 6.1±1.1 |

| ASD组 | 58 | 48/10 | 6.1±1.0 |

| t值 | -0.011 | -0.061 | |

| P值 | 0.918 | 0.952 |

注:[ASD]孤独症谱系障碍;[TD]正常发育。

1.2. 研究方法

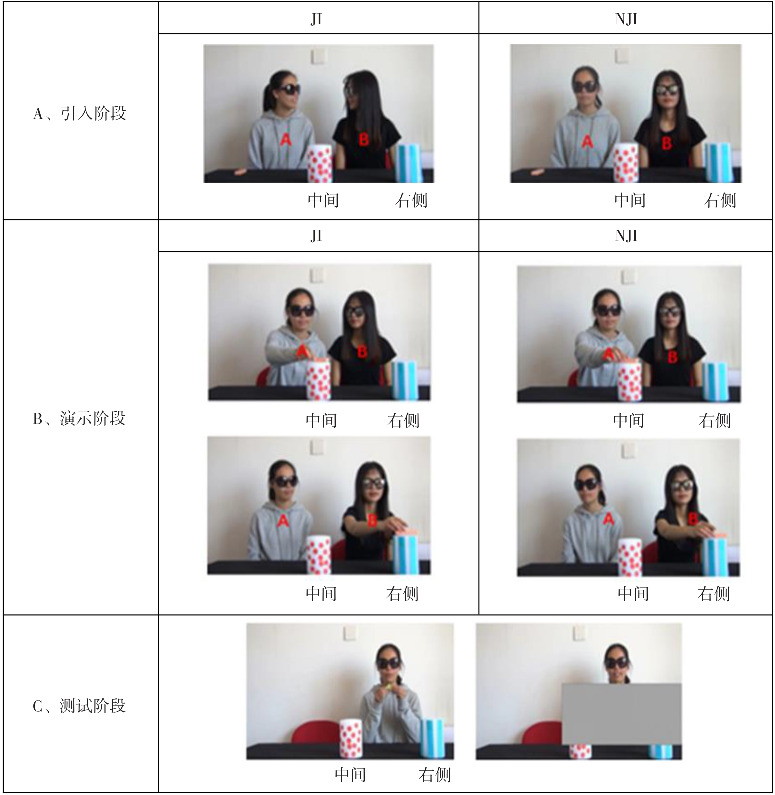

本研究采用Fawcett研究范式[13],被试观看一系列视频,并回答问题。视频分为3个阶段:引入阶段(播放1次)、演示阶段(播放3次)和测试阶段(播放3次)。引入阶段和演示阶段的视频分为NJI和JI两种社交场景,测试视频无场景区分。两组被试随机分配观看不同场景视频。

引入阶段的场景如图1A所示,桌后并排坐着演员A和演员B,两者均佩戴墨镜(降低演员眼神对被试的潜在干扰)。桌上放置两根并列柱子,其中一个柱子位于两演员之间,另一柱子位于演员B的左侧(即右侧柱子)。在JI场景下,两位演员相互转头看向对方并微笑,进行简短对话(演员A:“我喜欢玩积木”,演员B:“我今天要去玩积木”)。而在NJI场景中,两名演员的对话内容与JI场景相同,但演员B在回应演员A时延迟约1 s。在JI场景中,两名演员的言语交流流畅而自然,而在NJI场景中,两名演员各自发表言论,无眼神交流。

图1. 试验流程 [JI]联合意图;[NJI]非联合意图。.

演示阶段播放3次,如图1B所示。演员A拿起一块积木,高声数三下,并将其放置于中间柱子上,接着口头表达“好了”。随后,演员B高声数三下,取下中间柱子上的积木并放置于右侧柱子上,然后表示“好了”。在JI场景下,演员A和演员B在对方放置积木时注视着对方的动作,动作完成后,两人互相对视并微笑。但在NJI场景下,演员A和演员B在对方放置积木的过程中,视线转移到其他地方,且动作完成后无任何眼神交流。

测试阶段播放3次,如图1C所示,测试阶段视频不再区分不同场景。演员B离开,演员A则坐到演员B的位置上,从桌下取出一块积木,将其放置于两根柱子之间,接着,演员A对着镜头说:“我又找到了一块积木,我应该把它放在哪里呢?”此时,视频中将会出现一块挡板,遮蔽演员A的上半身、手臂及两根柱子,使得被试无法观察其将积木放置在何处。

红色、蓝色柱子及两位演员的位置在试验过程中平衡出现。

1.3. 试验程序

采用TobiiX3-120眼动仪进行视觉追踪,采样率为120 Hz。被试坐在距离眼动仪约60 cm的舒适椅子上,先进行眼动仪5点校准,随后进入正式试验。

1.4. 眼动数据特征提取

3名被试(2名ASD男童和1名TD女童)的眼动数据因数据缺失率较高(分别为100%、95.62%和100%)而被剔除,最终数据集包括56名ASD儿童和49名TD儿童。使用Tobii Studio软件提取眼动追踪数据中的视觉注视特征。本研究基于场景中人物和人物从事的活动划分为11个兴趣区(area of interest, AOI),包括人的头部(眼、口、面部)、身体(手)、活动(圆柱和积木)(图2)。

图2. 11个AOI划分示意图.

对原始眼动数据进行划分,按照视频引入阶段、演示阶段1、演示阶段2、演示阶段3、测试阶段1、测试阶段2、测试阶段3等7个试验阶段进行分割,得到77个基于AOI的特征(7片段×11个AOI)。

对两组被试在观看7个视频过程中,注视上述11个AOI的注视时长占比和注视次数占比进行计算,并将其用于ML分类建模。注视时长占比定义为:在观看某段视频时,注视某个特定AOI的总持续时间与该段视频总有效注视时间之比。注视次数占比定义为:在观看某段视频时,注视某个特定AOI的总次数与该段视频总注视次数之比。如“中间柱子演示1_注视时长占比”,代表被试在观看演示阶段1视频期间对中间柱子的注视时间占本段视频总注视时间的比例。

考虑到场景(NJI和JI)因素对试验结果的影响,将场景也加入特征集中,共构造157个特征:(11个AOI×7视频)×(2种眼动数据统计量:注视时长占比和注视次数占比)+年龄+性别+(社会场景:NJI和JI),即(11×7×2+1+1+1=157。

1.5. ML程序

通过算法,使得机器能从大量历史数据中学习规律,从而对新的样本进行智能识别或对未来进行预测[36-39]。

1.5.1. 数据集

依据提取的157个特征,组成108(被试)×157(特征)的数据集。删除有效数据低于30%的43个指标以及数据缺失率较高的3个被试数据,最终,用于ML的原始数据集为105(被试)×114(特征)的矩阵。

1.5.2. 分类器

首先采用常规的分类器,包括支持向量机(support vector machine)、线性判别算法(linear discriminant analysis)、决策树(decision tree, DT)、随机森林(random forest)和邻近算法(K-nearest neighbor, KNN)进行分类。以上各分类器在既往ASD识别方面已有广泛应用[33,36-39]。

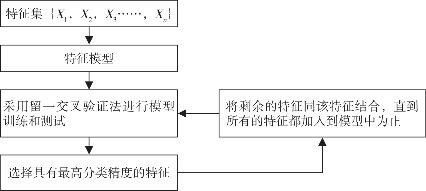

1.5.3. 分类

ML流程如图3所示。为最大限度减少潜在的过拟合问题,在ML训练模型和测试模型中实施留一交叉验证法,通过计算其准确度、灵敏度和特异度以评估ML模型的分类性能。

图3. ML流程图.

2. 结果

将114个特征引入ML模型,采用支持向量机、线性判别算法、DT、随机森林、KNN(K=1、3、5、7)等8种分类器进行分析。结果显示,采用DT、KNN(K=1)、KNN(K=5)分类器的分类准确度均可达到80%以上,分别为80.95%、80.95%和81.90%。

为进一步提高分类准确度,尝试在原有指标基础上构建新指标。遵循保证新指标物理特征可解释性和减少运算量的两大原则,对原指标进行如下处理:(1)由于测试阶段在前一步ML中贡献度相对较小,后期ML不再将测试阶段的特征计入;(2)按照物理特征可解释性,将数据按照阶段、类型(注视时长占比和注视次数占比)分类,共分为8组,即(1个引入阶段+3个演示阶段)×2(注视时长占比和注视次数占比);(3)同一类型、同一阶段的AOI指标两两求和得到新指标;(4)由于眼和口分别与面部有重合部分,因此眼和口不再分别与面部做求和处理。按照上述原则,最后用于处理的数据集为105(被试)×370(特征)矩阵。

将组合后的指标再次输入8种分类器,采用相同的ML方法,结果显示,DT分类器分类准确度最高,准确度高达91.43%,灵敏度为92.86%,特异度为89.80%,区分ASD组和TD组分类器的受试者操作特征曲线的曲线下面积为0.909(P<0.001),说明分类器性能优良,见图4。表2展示了用于区分ASD和TD的10组关键特征,以及随着特征组合的变化而得到的DT分类性能。

图4. DT分类器最高分类准确度对应的受试者操作特征曲线.

表2.

有效区分ASD组和TD组的特征及DT分类性能随特征组合的变化

| 特征组合 | 特征名称 | 准确度 (%) | 灵敏度 (%) | 特异度 (%) |

|---|---|---|---|---|

| 组合1 | 口-A演示2_注视次数占比+手-B演示2_注视次数占比 | 72.38 | 75.00 | 69.39 |

| 组合2 | ~+右侧柱子演示3_注视时长占比+手-A演示3_注视时长占比 | 79.05 | 82.14 | 75.51 |

| 组合3 | ~+眼-B演示2_注视次数占比+手-B演示2_注视次数占比 | 80.00 | 85.71 | 73.47 |

| 组合4 | ~+积木演示3_注视次数占比+手-B演示3_注视次数占比 | 80.00 | 83.93 | 75.51 |

| 组合5 | ~+口-A引入_注视次数占比+积木引入_注视次数占比 | 80.00 | 83.93 | 75.51 |

| 组合6 | ~+手-A演示2_注视次数占比+手-B演示2_注视次数占比 | 80.95 | 80.36 | 81.63 |

| 组合7 | ~+眼-B演示1_注视次数占比+中间柱子演示1_注视次数占比 | 85.71 | 85.71 | 85.71 |

| 组合8 | ~+中间柱子演示3_注视次数占比+手-A演示3_注视次数占比 | 89.52 | 91.07 | 87.76 |

| 组合9 | ~+面部-A演示3_注视次数占比+右侧柱子演示3_注视次数占比 | 90.48 | 91.07 | 89.80 |

| 组合10 | ~+面部-B引入_注视时长占比+右侧柱子引入_注视时长占比 | 91.43 | 92.86 | 89.80 |

注:~表示在前一次迭代中的所有特征,如组合10的~表示在第10次迭代中之前选择的所有9组特征。

表3为两种社交场景下10组混合特征模型的混淆矩阵。NJI下的分类精度达98.15%;JI下分类精度为84.30%,提示NJI下指标对ASD和TD的区分能力更强。

表3.

两种社交场景下基于DT最高分类精度a的混淆矩阵

| 组别 | NJI | JI | ||

|---|---|---|---|---|

| TD组 | ASD组 | TD组 | ASD组 | |

| TD组 | 25(TN) | 0(FN) | 19(TN) | 4(FN) |

| ASD组 | 1(FP) | 28(TP) | 4(FP) | 24(TP) |

注:a示分类精度=(TP+TN)/(TP+FP+FN+TN)。[NJI]非联合意图;[JI]联合意图;[TD]正常发育;[ASD]孤独症谱系障碍;[TN]真阴性数;[FP]假阳性数;[FN]假阴性数;[TP]真阳性数。

3. 讨论

本研究将AOI注视时长占比和注视次数占比作为指标,使用DT分类器对18个关键指标进行两两配对,组成10个指标组,可获得高达91.43%的高分类准确度,表明本研究建立了一个眼动追踪技术和ML算法相结合的有效辅助诊断ASD儿童的模型,为临床上依据客观指标开展ASD的辅助诊断提供了证据支持。

本研究中18个关键指标分别对应活动场景中人的面部、身体和活动范围,表明两组儿童在对社交场景的主要组成部分的注意方面均存在显著差异,这和既往考察ASD儿童对社交场景的注意研究[30]一致。Kaliukhovich等[17]发现,与TD儿童相比,ASD儿童在社交场景中对他人面部的关注较少。而本研究更进一步发现,ASD儿童在JI社交场景中对角色活动的关注也明显减少,表明在JI条件下,所需的较高认知负荷可能促成了这种注意力模式。

与既往ML在ASD早期诊断中的应用研究[26,40-41]相比,本研究的范式更为复杂,通过对话和表情传达社交意图,在社会环境中嵌入了较多的非社会性因素,且视频持续时间较长。本研究涉及的样本规模较大(108名),与之前基于眼动的ML研究[28-32]相比,准确度方面表现相当。通过构建新的指标发现,指标重构是提高ML准确度的一个有效手段,为后续采用ML进行ASD分类提供借鉴。

本研究也存在一些局限性:(1)仅使用眼动数据进行预测,未来研究应综合考虑与其他模态数据的融合,如脑电图和神经成像,以提高模型准确性;(2)仅研究了一种社交场景,未来研究应扩展到不同类型的社交情境,以了解注意力模式的差异;(3)研究样本仅涵盖高功能ASD儿童,这一选择基于许多低功能ASD儿童在进行眼动仪的校正等试验程序时可能会遇到困难,表现出较低的合作度。样本选择的单一性限制了研究的外推性,因此未来的研究需优化试验程序,以便更全面地研究整个ASD儿童的注意模式。

综上所述,本研究以眼动注视指标为特征,采用不同ML算法对ASD和TD儿童进行分类,分类准确度达到80%以上。对特征进行重构后,分类准确度提升至91.43%,这一发现不仅验证了ML算法在自动识别ASD方面的潜力,同时突显了重构指标在提高分类准确度方面的效果,为未来改进ML算法性能提供了可行的方向。

基金资助

国家自然科学基金面上项目(31971009;82171539);中国科学院青年创新促进会项目(2021082)。

利益冲突声明

所有作者声明无利益冲突。

作者贡献

程蓉负责研究设计、数据分析、论文撰写;赵众负责提供关键理论支持,对论文的结构和语言进行修订;侯文文负责研究实施、数据收集和数据解释;周刚、廖昊天、张雪负责数据分析;李晶负责项目整体规划设计和实施,协调团队工作,负责论文的最终撰写和修订。

参 考 文 献

- 1. Zwaigenbaum L, Penner M. Autism spectrum disorder: advances in diagnosis and evaluation[J]. BMJ, 2018, 361: k1674. DOI: 10.1136/bmj.k1674. [DOI] [PubMed] [Google Scholar]

- 2. Falkmer T, Anderson K, Falkmer M, et al. Diagnostic procedures in autism spectrum disorders: a systematic literature review[J]. Eur Child Adolesc Psychiatry, 2013, 22(6): 329-340. DOI: 10.1007/s00787-013-0375-0. [DOI] [PubMed] [Google Scholar]

- 3. Li N, Chen G, Song X, et al. Prevalence of autism-caused disability among Chinese children: a national population-based survey[J]. Epilepsy Behav, 2011, 22(4): 786-789. DOI: 10.1016/j.yebeh.2011.10.002. [DOI] [PubMed] [Google Scholar]

- 4. Masi A, DeMayo MM, Glozier N, et al. An overview of autism spectrum disorder, heterogeneity and treatment options[J]. Neurosci Bull, 2017, 33(2): 183-193. DOI: 10.1007/s12264-017-0100-y. [DOI] [PMC free article] [PubMed] [Google Scholar]

- 5. Hyman SL, Levy SE, Myers SM, et al. Identification, evaluation, and management of children with autism spectrum disorder[J]. Pediatrics, 2020, 145(1): e20193447. DOI: 10.1542/peds.2019-3447. [DOI] [PubMed] [Google Scholar]

- 6. Shaw KA, Bilder DA, McArthur D, et al. Early identification of autism spectrum disorder among children aged 4 years: Autism and Developmental Disabilities Monitoring Network, 11 Sites, United States, 2020[J]. MMWR Surveill Summ, 2023, 72(1): 1-15. DOI: 10.15585/mmwr.ss7201a1. [DOI] [PMC free article] [PubMed] [Google Scholar]

- 7. Mandell DS, Novak MM, Zubritsky CD. Factors associated with age of diagnosis among children with autism spectrum disorders[J]. Pediatrics, 2005, 116(6): 1480-1486. DOI: 10.1542/peds.2005-0185. [DOI] [PMC free article] [PubMed] [Google Scholar]

- 8. Dalton JC, Crais ER, Velleman SL. Joint attention and oromotor abilities in young children with and without autism spectrum disorder[J]. J Commun Disord, 2017, 69: 27-43. DOI: 10.1016/j.jcomdis.2017.06.002. [DOI] [PubMed] [Google Scholar]

- 9. Woo BM, Spelke ES. Infants and toddlers leverage their understanding of action goals to evaluate agents who help others[J]. Child Dev, 2023, 94(3): 734-751. DOI: 10.1111/cdev.13895. [DOI] [PubMed] [Google Scholar]

- 10. Tomasello M, Carpenter M, Call J, et al. Understanding and sharing intentions: the origins of cultural cognition[J]. Behav Brain Sci, 2005, 28(5): 675-691. DOI: 10.1017/S0140525X05000129. [DOI] [PubMed] [Google Scholar]

- 11. Fawcett C, Kreutz G. Twelve-month-old infants' physiological responses to music are affected by others' positive and negative reactions[J]. Infancy, 2021, 26(6): 784-797. DOI: 10.1111/infa.12415. [DOI] [PubMed] [Google Scholar]

- 12. Ulber J, Hamann K, Tomasello M. How 18- and 24-month-old peers divide resources among themselves[J]. J Exp Child Psychol, 2015, 140: 228-244. DOI: 10.1016/j.jecp.2015.07.009. [DOI] [PubMed] [Google Scholar]

- 13. Fawcett C, Gredebäck G. Infants use social context to bind actions into a collaborative sequence[J]. Dev Sci, 2013, 16(6): 841-849. DOI: 10.1111/desc.12074. [DOI] [PubMed] [Google Scholar]

- 14. Fawcett C, Tunçgenç B. Infants' use of movement synchrony to infer social affiliation in others[J]. J Exp Child Psychol, 2017, 160: 127-136. DOI: 10.1016/j.jecp.2017.03.014. [DOI] [PubMed] [Google Scholar]

- 15. Fawcett C, Liszkowski U. Observation and initiation of joint action in infants[J]. Child Dev, 2012, 83(2): 434-441. DOI: 10.1111/j.1467-8624.2011.01717.x. [DOI] [PubMed] [Google Scholar]

- 16. Fitzpatrick P, Romero V, Amaral JL, et al. Social motor synchronization: insights for understanding social behavior in autism[J]. J Autism Dev Disord, 2017, 47(7): 2092-2107. DOI: 10.1007/s10803-017-3124-2. [DOI] [PubMed] [Google Scholar]

- 17. Kaliukhovich DA, Manyakov NV, Bangerter A, et al. Social attention to activities in children and adults with autism spectrum disorder: effects of context and age[J]. Mol Autism, 2020, 11(1): 79. DOI: 10.1186/s13229-020-00388-5. [DOI] [PMC free article] [PubMed] [Google Scholar]

- 18. Frazier TW, Strauss M, Klingemier EW, et al. A meta-analysis of gaze differences to social and nonsocial information between individuals with and without autism[J]. J Am Acad Child Adolesc Psychiatry, 2017, 56(7): 546-555. DOI: 10.1016/j.jaac.2017.05.005. [DOI] [PMC free article] [PubMed] [Google Scholar]

- 19. 侯文文, 李晶, 李婷玉, 等. 孤独症谱系障碍患者社会性注意异常的机制[J]. 中国科学(生命科学), 2019, 49(1): 59-66. DOI: 10.1360/N052018-00151. [DOI] [Google Scholar]

- 20. 李晶, 朱莉琪. 高功能孤独症儿童的合作行为[J]. 心理学报, 2014, 46(9): 1301-1316. DOI: 10.3724/SP.J.1041.2014.01301. 24557685 [DOI] [Google Scholar]

- 21. Liebal K, Colombi C, Rogers SJ, et al. Helping and cooperation in children with autism[J]. J Autism Dev Disord, 2008, 38(2): 224-238. DOI: 10.1007/s10803-007-0381-5. [DOI] [PMC free article] [PubMed] [Google Scholar]

- 22. Helminen TM, Leppänen JM, Eriksson K, et al. Atypical physiological orienting to direct gaze in low-functioning children with autism spectrum disorder[J]. Autism Res, 2017, 10(5): 810-820. DOI: 10.1002/aur.1738. [DOI] [PubMed] [Google Scholar]

- 23. Alcañiz M, Chicchi-Giglioli IA, Carrasco-Ribelles LA, et al. Eye gaze as a biomarker in the recognition of autism spectrum disorder using virtual reality and machine learning: a proof of concept for diagnosis[J]. Autism Res, 2022, 15(1): 131-145. DOI: 10.1002/aur.2636. [DOI] [PubMed] [Google Scholar]

- 24. Kong XJ, Wei Z, Sun B, et al. Different eye tracking patterns in autism spectrum disorder in toddler and preschool children[J]. Front Psychiatry, 2022, 13: 899521. DOI: 10.3389/fpsyt.2022.899521. [DOI] [PMC free article] [PubMed] [Google Scholar]

- 25. Wan G, Kong X, Sun B, et al. Applying eye tracking to identify autism spectrum disorder in children[J]. J Autism Dev Disord, 2019, 49(1): 209-215. DOI: 10.1007/s10803-018-3690-y. [DOI] [PubMed] [Google Scholar]

- 26. Jiang M, Francis SM, Srishyla D, et al. Classifying individuals with ASD through facial emotion recognition and eye-tracking[J]. Annu Int Conf IEEE Eng Med Biol Soc, 2019, 2019: 6063-6068. DOI: 10.1109/EMBC.2019.8857005. [DOI] [PubMed] [Google Scholar]

- 27. Kanhirakadavath MR, Chandran MSM. Investigation of eye-tracking scan path as a biomarker for autism screening using machine learning algorithms[J]. Diagnostics (Basel), 2022, 12(2): 518. DOI: 10.3390/diagnostics12020518. [DOI] [PMC free article] [PubMed] [Google Scholar]

- 28. Liu W, Li M, Yi L. Identifying children with autism spectrum disorder based on their face processing abnormality: a machine learning framework[J]. Autism Res, 2016, 9(8): 888-898. DOI: 10.1002/aur.1615. [DOI] [PubMed] [Google Scholar]

- 29. Minissi ME, Chicchi Giglioli IA, Mantovani F, et al. Assessment of the autism spectrum disorder based on machine learning and social visual attention: a systematic review[J]. J Autism Dev Disord, 2022, 52(5): 2187-2202. DOI: 10.1007/s10803-021-05106-5. [DOI] [PMC free article] [PubMed] [Google Scholar]

- 30. Wei Q, Cao H, Shi Y, et al. Machine learning based on eye-tracking data to identify autism spectrum disorder: a systematic review and meta-analysis[J]. J Biomed Inform, 2023, 137: 104254. DOI: 10.1016/j.jbi.2022.104254. [DOI] [PubMed] [Google Scholar]

- 31. Zhao Z, Tang H, Zhang X, et al. Classification of children with autism and typical development using eye-tracking data from face-to-face conversations: machine learning model development and performance evaluation[J]. J Med Internet Res, 2021, 23(8): e29328. DOI: 10.2196/29328. [DOI] [PMC free article] [PubMed] [Google Scholar]

- 32. Zhao Z, Wei J, Xing J, et al. Use of oculomotor behavior to classify children with autism and typical development: a novel implementation of the machine learning approach[J]. J Autism Dev Disord, 2023, 53(3): 934-946. DOI: 10.1007/s10803-022-05685-x. [DOI] [PubMed] [Google Scholar]

- 33. 李西, 田真玲, 姜孟. 机器学习在孤独症筛查与诊断中的应用研究进展[J]. 中国特殊教育, 2022(9): 47-54. DOI: 10.3969/j.issn.1007-3728.2022.09.006. [DOI] [Google Scholar]

- 34. American Psychiatric Association, DSM-5 Task Force . Diagnostic and Statistical Manual of Mental Disorders: DSM-5[M]. 5th ed. Washington: American Psychiatric Association, 2013: 36-37. [Google Scholar]

- 35. 张厚粲, 王晓平. 瑞文标准推理测验在我国的修订[J]. 心理学报, 1989, 21(2): 113-121. [Google Scholar]

- 36. Kang J, Han X, Song J, et al. The identification of children with autism spectrum disorder by SVM approach on EEG and eye-tracking data[J]. Comput Biol Med, 2020, 120: 103722. DOI: 10.1016/j.compbiomed.2020.103722. [DOI] [PubMed] [Google Scholar]

- 37. 康健楠, 韩晓雅, 耿新玲, 等. 基于眼动追踪技术的孤独症谱系障碍儿童面孔异常加工识别研究[J]. 中国康复医学杂志, 2022, 37(7): 933-936. DOI: 10.3969/j.issn.1001-1242.2022.07.012. [DOI] [Google Scholar]

- 38. 杨剑锋, 乔佩蕊, 李永梅, 等. 机器学习分类问题及算法研究综述[J]. 统计与决策, 2019, 35(6): 36-40. DOI: 10.13546/j.cnki.tjyjc.2019.06.008. [DOI] [Google Scholar]

- 39. 张润, 王永滨. 机器学习及其算法和发展研究[J]. 中国传媒大学学报(自然科学版), 2016, 23(2): 10-18. DOI: 10.3969/j.issn.1673-4793.2016.02.002. [DOI] [Google Scholar]

- 40. Chita-Tegmark M. Social attention in ASD: a review and meta-analysis of eye-tracking studies[J]. Res Dev Disabil, 2016, 48: 79-93. DOI: 10.1016/j.ridd.2015.10.011. [DOI] [PubMed] [Google Scholar]

- 41. Yaneva V, Ha LA, Eraslan S, et al. Detecting high-functioning autism in adults using eye tracking and machine learning[J]. IEEE Trans Neural Syst Rehabil Eng, 2020, 28(6): 1254-1261. DOI: 10.1109/TNSRE.2020.2991675. [DOI] [PubMed] [Google Scholar]