Abstract

目的

糖尿病足溃疡的测量是临床诊断的重要一环,高精度测量与评估是高效管理的保障。目前临床上缺乏精确、便捷的测量工具。近年来人工智能技术在图形分割与识别领域中彰显了一定的潜力。本研究旨在基于深度学习方法对糖尿病足溃疡影像进行分析,构建糖尿病足溃疡智能测量模型并对其进行初步验证。

方法

选取1 042例糖尿病足溃疡的图像,对溃疡边缘及不同的颜色区域进行人工标注,其中782张作为训练数据集,260张作为测试数据集。采用Mask RCNN溃疡组织颜色语义分割及RetinaNet标尺数字刻度目标检测来建立模型,将训练数据集输入模型并进行迭代。利用测试数据集验证智能测量模型。

结果

基于深度学习建立了糖尿病足溃疡的智能测量模型,训练集和测试集组织颜色区域分割的mAP@.5IOU(mean average precision@.5 intersection over union)分别为87.9%和63.9%,标尺刻度数字检测的mAP@.5IOU分别为96.5%和83.4%。以测试集的人工测量结果为参照,智能测量结果的平均误差约3 mm。

结论

糖尿病足溃疡智能测量模型测量糖尿病足溃疡具有较高的精确度及良好的鲁棒性,未来的研究可采用更大规模的数据样本对模型做进一步优化。

Keywords: 深度学习, 慢性伤口, 糖尿病足溃疡, 智能测量

Abstract

Objective

The measurement of diabetic foot ulcers is important for the success in diabetic foot ulcer management. At present, it lacks the accurate and convenient measurement tools in clinical. In recent years, artificial intelligence technology has demonstrated the potential application value in the field of image segmentation and recognition. This study aims to construct an intelligent measurement model of diabetic foot ulcers based on the deep learning method, and to conduct preliminary verification.

Methods

The data of 1 042 diabetic foot ulcers clinical samples were collected. The ulcers and color areas were manually labeled, of which 782 were used as the training data set and 260 as the test data set. The Mask RCNN ulcer tissue color semantic segmentation and RetinaNet scale digital scale target detection were used to build a model. The training data set was input into the model and iterated. The test data set was used to verify the intelligent measurement model.

Results

This study established an intelligent measurement model of diabetic foot ulcers based on deep learning. The mean average precision@.5 intersection over union (mAP@.5IOU) of the color region segmentation in the training set and the test set were 87.9% and 63.9%, respectively; the mAP@.5IOU of the ruler scale digital detection in the training set and the test set were 96.5% and 83.4%, respectively. Compared with the manual measurement result of the test sample, the average error of the intelligent measurement result was about 3 mm.

Conclusion

The intelligent measurement model has good accuracy and robustness in measuring the diabetic foot ulcers. Future research can further optimize the model with larger-scale data samples.

Keywords: deep learning, chronic wound, diabetic foot ulcers, intelligent measurement

糖尿病足溃疡(diabetic foot ulcer,DFU)是糖尿病的严重并发症,其临床的护理及诊断都需要精确的测量指标[1]。国际伤口愈合协会将慢性伤口定义为无法通过正常、有序和及时的修复过程达到解剖和功能上的完整状态的伤口[2]。糖尿病患者一旦发生慢性伤口,将增加致残、致死风险,给患者及其家庭带来沉重的负担[3]。伤口测量是伤口管理的重要内容[4],虽然临床上已有多种伤口测量方法,但各有局限[5-11]。在伤口的临床诊治过程中,医务人员若不能准确地测量伤口面积,将会影响后期的规范化治疗[12]。

虽然,对于慢性伤口,临床上使用最为普遍的仍然是传统的手工测量方法,但是研究[13]发现传统的方法评估慢性伤口的有效性和可靠性较低。深度学习技术作为人工智能的热门研究领域,近年备受关注。它是一类算法的集合,通过建立模拟人脑的分层结构来实现对外部输入数据从低级到高级的特征提取,从而达到解释外部数据的目的[14-15]。近年来,基于深度学习的人工智能技术已经被运用到肿瘤、心血管疾病和糖尿病的治疗中,并取得了一定的成果[16-18]。将深度学习技术大规模运用于128 175张糖尿病患者的眼底照片中,检测有无糖尿病视网膜病变,结果表明灵敏度和特异度分别为96.1%和93.9%[19]。基于深度学习技术的糖尿病视网膜病变筛查软件(Eye PACS-1)能够准确诊断糖尿病视网膜病变,以明确诊断为中、重度糖尿病视网膜病变或糖尿病黄斑水肿为参照,其灵敏度为90.3%,特异度为98.1%[20]。此外,智能医学影像识别技术在糖尿病并发症中的运用亦取得了长足进步,Goyal等[21]提供了一份1 775张DFU图像样本,分别以目标检测、语义分割2种深度学习方法,智能定位溃疡所在位置及轮廓,其灵敏度达到了91.8%。Chino等[22]提出的自动化皮肤溃疡区域评估方法(automatic skin ulcer region assessment,ASURA)能够比较精准地分割伤口区域并测量伤口面积。

近年来深度学习技术在DFU伤口领域的运用取得了一定的成果,但研究报道甚少,且主要集中在伤口溃疡的区域定位方面,未涉及颜色区域的划分以及测量指标的获取。本研究采用深度学习技术进行伤口测量过程的建模,完成伤口区域定位、标尺刻度检测、测量指标计算与换算3个步骤,基于coco目标检测指标mAP@.5IOU(mean average precision@.5 intersection over union)对伤口区域定位模型和标尺刻度检测模型进行评估与调优,以实现对溃疡伤口的长、宽、面积及颜色区域占比4项指标的测量,旨在提供一种基于大规模DFU图像的慢性伤口智能测量方法,为临床医生评估伤口溃疡的发展情况提供重要的依据。

1. 资料与方法

1.1. 数据来源

本研究已获得中南大学护理学院护理与行为医学研究伦理审查委员会批准(审批号:E202021)。DFU图像样本来源于中南大学湘雅医院糖尿病足防治中心(以下简称为本中心)。样本采集的要求:1)建模阶段。溃疡边缘清晰,不同颜色组织的范围边界区分明显,且拍摄视角尽可能为90°,同时标尺类型需保持一致,标尺与伤口尽量处于相对于镜头的同一平面,但不限定必须有标尺。2)应用阶段。将患处放于水平位置,并将一次性标尺平置于伤口面下缘,操作人员在自然光下固定单色背景通过手机摄像头进行拍照取样,手机摄像头与伤口面平行,固定90°视角,距离一般不超过1 m,以任意焦距对焦后完成拍摄。共采集符合要求的图像样本1 042例,其中782张作为训练数据集,260张作为测试数据集。

1.2. 数据标注

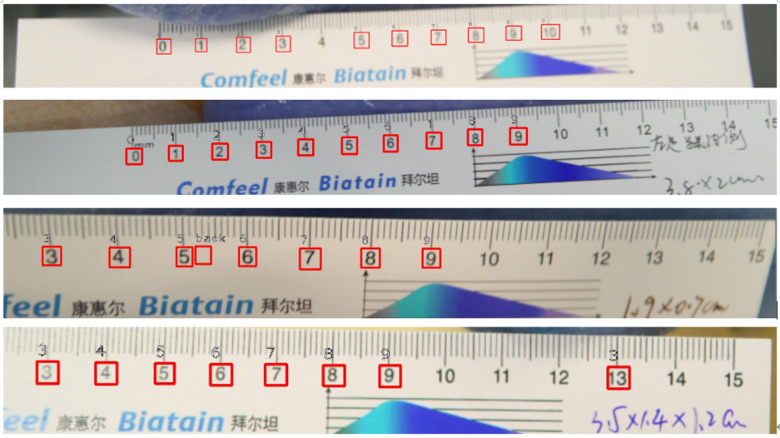

溃疡边缘及不同区域颜色的标注由本中心的医务人员,采用labelme软件完成标注。标注的红色、黄色、黑色、白色、粉色分别与临床上肉芽、腐肉、坏死、渗出、上皮组织对应,由于肌腱无颜色对应,直接使用“肌腱”作为类别名,标注为多边形掩膜。标注标尺数字刻度为0~9,标尺标注为矩形方框(图1)。由于一张图可能存在多个组织颜色区域嵌套的情况,部分组织颜色边界不清晰,溃疡形状不规则,人工描点对组织范围边界的标记无法达到100%精准。

图1.

标注示意图

Figure 1 Annotated schematic diagram

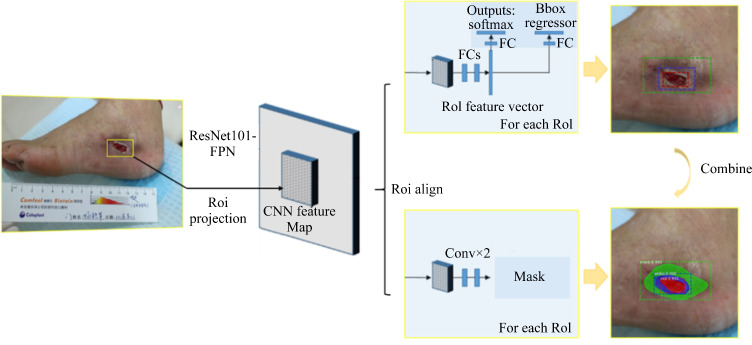

1.3. Mask RCNN分割建模

采用Mask RCNN网络架构对溃疡组织进行分割建模,网络输入为原图和伤口掩膜标注,网络输出为预测的伤口掩膜及方框(图2)。Mask RCNN采用ResNet101-FPN为主干网络提取溃疡区域的特征得到特征图(feature map),将网络生成的一系列Proposal候选框映射到特征图上进行ROI Align得到感兴趣区(region of interest,ROI),ROI接2个预测头,一个接全连接层做分类与回归,另一个接全卷积网络做掩膜分割,最终合并伤口的方框检测结果和掩膜检测结果。对输入组织颜色嵌套的掩膜区域做差集处理,以避免嵌套的2个掩膜区域在卷积过程中共用交集的像素特征。

图2.

Mask RCNN分割溃疡组织流程

Figure 2 Process of ulcer tissue segmentation by Mask RCNN

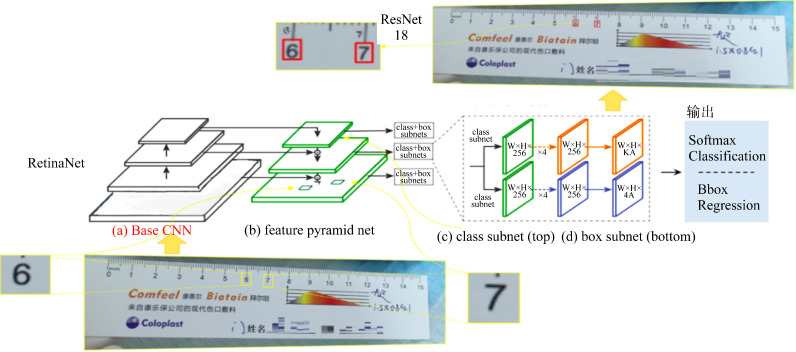

1.4. RetinaNet标尺数字建模

选择RetinaNet和Resnet18结合的二阶段网络来实现标尺数字的识别(图3)。在第1阶段,RetinaNet网络的输入为原图和标尺上“0~9”的方框标注,输出为网络预测的“0~9”的方框位置,此处RetinaNet不区分数字类别;将RetinaNet输出的“0~9”的方框位置从原图上裁剪下来作为第2阶段网络ResNet18的输入,ResNet18的输出为网络预测的数字类别。

图3.

RetinaNet数字刻度检测流程

Figure 3 Process of digital scale detection by RetinaNet

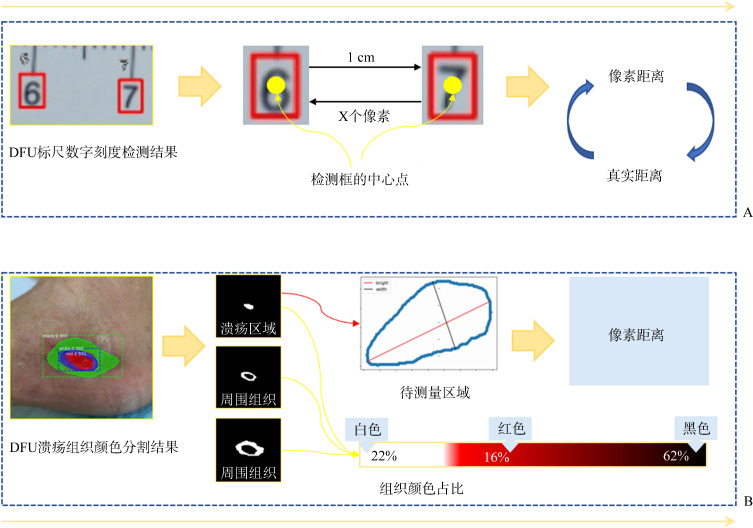

1.5. 测量结果的计算与换算

基于上述伤口区域定位和标尺数字定位的深度学习建模结果,测量过程分2步进行。第1步:对Mask RCNN分割溃疡组织得到的Mask,利用几何学计算像素距离的长、宽、面积;第2步:对RetinaNet数字刻度检测得到的检测框(Bbox),利用两个检测框中心点的距离关系将真实1 cm换算成图像上的像素距离(图4)。

图4.

换算真实结果(A)及几何学测量(B)的流程

Figure 4 Process of results conversion (A) and geometric measurement (B)

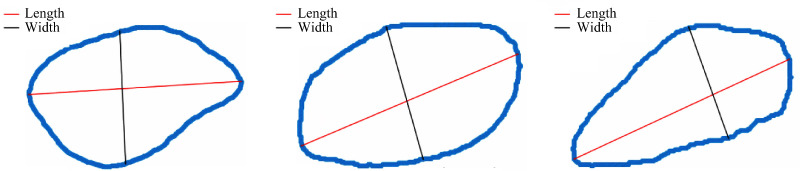

采用Mask RCNN分割溃疡组织后,利用opencv框架的轮廓检测区分不同组织颜色区域为1个单独的掩膜,并获取轮廓边界所有的像素点坐标。根据临床要求以掩膜区域内部最大的长度为标准,寻找掩膜轮廓上的凸包点,计算两个凸包点之间的欧式距离,将最长的欧式距离定义为长,垂直于长的最长线段定义为宽。计算过程涉及坐标原点的平移和坐标系的旋转,流程包含:1)计算伤口长(以Point_1、Point_2为端点);2)原溃疡组织边界坐标以图像的左上角为坐标原点,现改为以Point_1或Point_2为坐标原点;3)原溃疡组织边界坐标以图像的height为纵轴,现改为以已知的长所在的直线为纵轴;4)根据坐标原点、坐标轴的变化,获得平移与旋转后的图像;5)根据平移与旋转后的图像,计算原来的坐标原点在新坐标系下的坐标,并计算旋转的角度;6)根据旋转角度,对原坐标系下所有的边界点,做坐标转换;7)沿新纵轴方向,遍历y值,求得所有方向正交的宽度情况,并取长度最大者。面积计算主要是统计轮廓内部非零像素点,并以此为依据计算各颜色的占比(图5)。

图5.

几何学计算长度、宽度结果示例

Figure 5 Example of the result of geometric calculation of length and width

检测RetinaNet数字刻度之后,“0~9”数字刻度存在漏检、误检等情况(图6),按中心点横坐标递增的顺序排列检测框,剔除标签数字为“back”和非递增的标签数字异常检测框,计算两两相邻数字中心的距离,去掉最大值和最小值后取平均值,得到真实1 cm在图像上的像素距离。以标尺1 cm的像素距离作为换算标准,将长、宽、面积的像素距离换算为真实距离。假设某伤口长度的像素距离是180,标尺 1 cm代表的像素距离是90,则伤口长度的真实尺寸是2 cm(180×1/90 cm)。

图6.

RetinaNet数字刻度检测示例

Figure 6 Example of RetinaNet digital scale detection

1.6. 硬件环境和软件环境

拍摄设备均为Canon EOS M2,标注人员为本中心2位经过统一培训的专业医务人员,参照物统一为固定厂商及型号的一次性标尺。测试及部署服务器配置:CPU6核 Intel(R) Core(TM) i5-8600K CPU@ 3.60 GHz,GPU 2块 NVIDIA GTX1080 8 GB,内存 32 GB DDR3。

软件及框架配置:操作系统为Linux Centos7,深度学习框架为Torch1.1.0,应用容器引擎使用nvidia-docker。

1.7. 评估指标

溃疡组织颜色的精准度通过漏检率、误检率等指标来评估。其中,漏检率=1-灵敏度,代表相应组织未被检测出来的概率,误检率=1-特异度,代表相应组织类别检测错误的概率,值越小,效果越好。此外,引入coco目标检测指标mAP@.5IOU,对Mask RCNN分割和RetinaNet标尺数字检测的建模效果做评估。

2. 结 果

采集的1 042例DFU图像样本中红色组织的样本最多(634例,60.8%),其余依次为黄色组织(550例,52.8%)、黑色组织(493例,47.3%)、粉色组织(38例,3.6%)、肌腱(37例,3.6%)、白色组织(18例,1.7%)。通过对数据集进行人工标注,使用Mask RCNN网络架构建立溃疡分割模型,并通过RetinaNet和Resnet18结合的两阶段非端到端网络来实现标尺数字的识别,实现了溃疡智能测量模型的构建。

关于Mask RCNN分割定位模型的效果,训练集和测试集的灵敏度分别为90.6%和78.1%,特异度分别为92.5%和89.0%,mAP@.5IOU分别为87.9%和63.9%,存在一定的过拟合,测试集中漏检率为21.9%。对于推理效率,1 920×1 280分辨率的图片推理时长为124.8 ms(表1,2)。

表1.

糖尿病足Mask RCNN分割定位模型的效果

Table 1 Effect of Mask RCNN segmentation and localization model of diabetic foot Mask

| 组别 | 灵敏度/% | 特异度/% | 漏检率/% | 误检率/% | mAP@.5IOU/% |

|---|---|---|---|---|---|

| 训练集 | 90.6 | 92.5 | 9.4 | 7.5 | 87.9 |

| 测试集 | 78.1 | 89.0 | 21.9 | 11.0 | 63.9 |

表2.

糖尿病足 Mask RCNN分割定位模型的效率与资源 情况

Table 2 Efficiency and resources of Mask RCNN segmentation and localization model for diabetic foot

| 推理效率/ms | 模型大小/MB | 训练过程GPU内存占用/GB |

|---|---|---|

| 124.8/per img | 240 | 5.0/2 imgs |

在标尺数字检测模型的效果方面,RetinaNet训练集和测试集mAP@.5IOU分别为96.5%和83.4%,ResNet18训练集和测试集准确率分别为97.6%和98.4%。对于RetinaNet-ResNet18推理效率,1 920×1 280分辨率的图片推理时长为54.5 ms(表3,4)。

表3.

糖尿病足标尺 RetinaNet-ResNet18检测模型的效果

Table 3 Effect of diabetic foot scale RetinaNet-ResNet18 detection model

| 算法 | 类别数 | 样本数 | mAP/% | 准确率/% | |||

|---|---|---|---|---|---|---|---|

| 训练集 | 测试集 | 训练集 | 测试集 | ||||

| RetinaNet | 1(“div”) | 120 | 96.5 | 83.4 | |||

| ResNet18 | 10(“0-9”) | 1 067 | 97.6 | 98.4 | |||

表4.

糖尿病足标尺 RetinaNet-ResNet18检测模型的效率与资源情况

Table 4 Efficiency and resources of the diabetes foot scale RetinaNet-ResNet18 detection model

| 算法 | 推理效率/ms | 模型大小/MB | 训练过程GPU内存占用/GB |

|---|---|---|---|

| RetinaNet | 51.5/per img | 138.0 | 5.5/4 imgs |

| ResNet18 | 3.0/per img | 42.7 | 3.2/64 imgs |

在溃疡长、宽测量结果方面,选择标尺上带长、宽测量结果标定的90例样本,90例样本的平均误差约为3 mm,其中80%的样本测量的绝对误差小于2 mm(表5)。在不考虑网络带宽的前提下,1张1 920×1 280分辨率的DFU图像从接收数据返回到测量结果,响应时间在2 s内。

表5.

糖尿病足样本的测量效果

Table 5 Measurement results of diabetic foot samples

| 输入 | 测量类型 | 标定值/cm | 测量值/cm | 误差/cm | |||

|---|---|---|---|---|---|---|---|

| 长度 | 宽度 | 长度 | 宽度 | 长度 | 宽度 | ||

| IMG_6313.JPG | 黑色 | 4.00 | 1.50 | 3.83 | 1.39 | 0.17 | 0.11 |

| IMG_6321.JPG | 红色 | 2.60 | 1.80 | 2.82 | 2.04 | 0.22 | 0.24 |

| IMG_6342.JPG | 红色 | 1.90 | 1.20 | 1.78 | 1.17 | 0.12 | 0.03 |

| … | … | … | … | … | … | … | … |

| 平均误差 | 0.33 | 0.25 | |||||

3. 讨 论

本研究以检测DFU面积为目标,实现了伤口区域定位、标尺刻度检测、测量指标的计算与换算3个过程的建模,提出了一种精度、效率均比较可靠的DFU智能测量方法。该方法在国内首次将深度学习应用于DFU面积测量,实现了深度学习在DFU护理领域的应用,可协助医师对DFU的诊断和患者对病程的自主管理。

在本研究中,虽然溃疡组织的区域分布与颜色有映射关系,但没有严格的RGB数值界限,而且组织标签数量分布不均衡性明显,因此以ResNet101-FPN为基网络的端到端Mask RCNN做溃疡组织分割是针对于比较复杂的应用场景。本研究测试集的误差超过20%,考虑到标注标准不好统一,组织标签数量分布不均衡等客观不利因素,该结果已属较好。根据资源占用情况来看,模型复杂度较高在一定程度上易引起过拟合,但过拟合的主要原因还是在于应用场景的复杂性。

标尺刻度小数字一方面目标较小,需要根据标注框长、宽的统计情况调整适当的anchor大小,另一方面“0~9”数字图像的特征比较接近,需要采用单独的分类器加以区分。本研究采用两阶段非端到端模型,即第1阶段的无差别检测网络RetinaNet和第2阶段的有差别分类器ResNet18。两阶段网络的大小均属轻量级,为避免数字混淆不采用旋转、翻转等增广策略,因此明确要求平放标尺,推理速度极快。以人工测量结果作为对照标准,测试集的误差控制在3 mm,测量结果较为准确。对任意标尺“0~9”的刻度基本都能正确标识,尤其第二阶段分类器效果明显,第一阶段刻度检测稍有偏差,但并未对测量标准的换算产生影响,且多数字组合距离的计算与打分,让选择更加灵活多样,换算标准的计算结果鲁棒性更好。

由于采集的1 042例样本均未记录颜色区域手工测量的面积与占比两项指标,这两项指标缺乏标定值做对照,因此暂时只评估样本长和宽。从第一阶段溃疡组织分割的260例测试集样本中,选择标尺上带有长、宽测量结果标定的90例样本,做真实测量误差结果的统计评估。结果表明:伤口溃疡智能测量所得的长、宽非常接近对照的标定值,90例样本的平均绝对误差控制在约3 mm,其中80%的样本的绝对误差不超过2 mm,平均相对误差控制在10%,测试环境下效果显著。从智能测量推理的全流程效率方面来看,1张1920×1280分辨率的DFU图像,如果不考虑网络带宽的传输延时,从图像数据接收到测量结果返回,响应时间控制在2 s内,可极大满足慢性伤口智能分析的准确性、实时性的要求。

本研究存在以下不足。首先,构建的DFU智能测量模型主要的分析对象是普通摄像头拍摄的直观视觉的图像,目前只适用于伤口的可视化部分,对于一些存在骨组织损伤、口小底大的伤口、复杂窦道潜行等肉眼不可见的伤口,由于损伤组织暴露有限,难以对伤口的全局特征信息进行提取、处理与学习,故测量结果仅为肉眼可见部分的伤口面积,与实际面积可能存在一定的误差。尤其是对于临床需要的指标——伤口深度,以及深度伤口内部的具体情况,目前还无法检测。其次,对于一些存在多伤口区域的图像,当区域边缘连成一片时,可当作整片区域来处理和测量,但有些区域中间有类似正常皮肤,临床上是当作整片区域还是区分开来计算,没有固定标准,视测量人员的主观判断而异。因需要测量的区域分割对象定义不同,也可能导致一定的误差。

可从以下几方面展开进一步的研究:1)充实第1阶段伤口溃疡及颜色区域的标注样本,尤其是不均衡类别数较少的样本,以提高模型的泛化能力;2)结合3D扫描仪、CT、MRI等三维成像设备,挖掘伤口的三维立体特征信息,实现高精度的伤口多指标,尤其是深度指标的智能测量;3)完善复杂伤口测量模型的构建,比如采用不同方法实现不同颜色区域的分离、对肌腱、骨质等不同组织的识别,使其对多种类的复杂伤口组织具有普适性;4)伤口影像诊断模型的训练不应仅停留在对图像的分析上,应整合病史、体征、其他实验室和影像学检查结果等信息,进一步提升人工智能的综合诊断能力,从辅助诊断逐步上升到预测判断和辅助决策。

基金资助

“移动医疗”教育部-中国移动联合实验室第二期研发项目(2020MHL02011)。

This work was supported by the Phase II R&D Project from “Mobile Health” Ministry of Education-China Mobile Joint Laboratory, China (2020MHL02011).

利益冲突声明

作者声称无任何利益冲突。

原文网址

http://xbyxb.csu.edu.cn/xbwk/fileup/PDF/2021101138.pdf

参考文献

- 1. Lazarus GS, Cooper DM, Knighton DR, et al. Definitions and guidelines for assessment of wounds and evaluation of healing[J]. Wound Repair Regen, 1994, 2(3): 489-493. [DOI] [PubMed] [Google Scholar]

- 2. Mukherjee R, Tewary S, Routray A. Diagnostic and prognostic utility of non-invasive multimodal imaging in chronic wound monitoring: a systematic review[J]. J Med Syst, 2017, 41(3): 46-63. [DOI] [PubMed] [Google Scholar]

- 3. 董炜, 肖玉瑞, 吴敏洁, 等. 中国慢性难愈性创面诊疗思路及原则[J]. 中华烧伤杂志, 2018, 34(12): 868-873. [DOI] [PubMed] [Google Scholar]; DONG Wei, XIAO Yurui, WU Minjie, et al. Thoughts and principles of diagnosis and treatment of chronic refractory wounds in China[J]. Chinese Journal of Burns, 2018, 34(12): 868-873. [DOI] [PubMed] [Google Scholar]

- 4. Oyibo SO, Jude EB, Tarawneh I, et al. The effects of ulcer size and site, patient’s age, sex and type and duration of diabetes on the outcome of diabetic foot ulcers[J]. Diabet Med, 2001, 18(2): 133-138. [DOI] [PubMed] [Google Scholar]

- 5. Darwin ES, Jaller JA, Hirt PA, et al. Comparison of 3-dimensional wound measurement with laser-assisted and hand measurements: a retrospective chart review[J]. Wound Manag Prev, 2019, 1(65): 36-41. [PubMed] [Google Scholar]

- 6. Long DE, Villasante Tezanos AG, Wise JN, et al. A guide for using NIH Image J for single slice cross-sectional area and composition analysis of the thigh from computed tomography[J]. PLoS One, 2019, 14(2): 1-11. [DOI] [PMC free article] [PubMed] [Google Scholar]

- 7. Jorgensen LB, Sorensen JA, Jemec GB, et al. Methods to assess area and volume of wounds -a systematic review[J]. Int Wound J, 2016, 13(4): 540-553. [DOI] [PMC free article] [PubMed] [Google Scholar]

- 8. Jorgensen LB, Skov Jeppesen SM, Halekoh U, et al. Validation of three‐dimensional wound measurements using a novel 3D‐WAM camera[J]. Wound Repair Regen, 2018, 26(6): 456-462. [DOI] [PubMed] [Google Scholar]

- 9. Gholami P, Ahmadipajouh M A, Abolftahi N, et al. Segmentation and Measurement of Chronic Wounds for Bioprinting[J]. IEEE J Biomed Health Inform, 2018, 22(4): 1269-1277. [DOI] [PubMed] [Google Scholar]

- 10. Shamata A, Thompson T. Documentation and analysis of traumatic injuries in clinical forensic medicine involving structured light three-dimensional surface scanning versus photography[J]. J Forensic Leg Med, 2018, 58: 93-100. [DOI] [PubMed] [Google Scholar]

- 11. Van Hecke LL, De Mil TA, Haspeslagh M, et al. Comparison of a new laser beam wound camera and a digital photoplanimetry-based method for wound measurement in horses[J]. Vet J, 2015, 203(3): 309-314. [DOI] [PubMed] [Google Scholar]

- 12. National Institute for Health and Care Excellence . Diabetic foot problems: prevention and management (NG 19)[EB/OL]. (2015-08-26) [2021-10-26]. https://www.nice.org.uk/guidance/ng19. [PubMed] [Google Scholar]

- 13. Van Netten JJ, Clark D, Lazzarini PA, et a1. The validity and reliability of remote diabetic foot ulcer assessment using mobile phone images[J]. Sci Rep, 2017, 7(1): 9480. [DOI] [PMC free article] [PubMed] [Google Scholar]

- 14. Wong TY, Bressler NM. Artificial intelligence with deep learning technology looks into diabetic retinopathy screening[J]. JAMA, 2018, 316(22): 2366-2367. [DOI] [PubMed] [Google Scholar]

- 15. 胡越, 罗东阳, 花奎, 等. 关于深度学习的综述与讨论[J]. 智能系统学报, 2019, 14(1): 1-19. [Google Scholar]; HU Yue, LUO Dongyang, HUA Kui, et al. Overview on deep learning[J]. CAAI Transactions on Intelligent Systems, 2019, 14(1): 1-19. [Google Scholar]

- 16. Lim JZ, Ng NS, Thomas C. Prevention and treatment of diabetic foot ulcers[J]. J R Soc Med, 2017, 110(3): 104-109. [DOI] [PMC free article] [PubMed] [Google Scholar]

- 17. Paisey RB, Abbott A, Levenson R, et al. Diabetes‐related major lower limb amputation incidence is strongly related to diabetic foot service provision and improves with enhancement of services: peer review of the South‐West of England[J]. Diabet Med, 2018, 35(1): 53-62. [DOI] [PMC free article] [PubMed] [Google Scholar]

- 18. 付常洋, 王瑜, 肖洪兵, 等. 基于深度学习与结构磁共振成像的抑郁症辅助诊断[J]. 智能系统学报, 2021, 16(3): 544-551. [Google Scholar]; FU Changyang, WANG Yu, XIAO Hongbing, et al. Assisted diagnosis of major depression disorder using deep learning and structural magnetic resonance imaging[J]. CAAI Transactions on Intelligent Systems, 2021, 16(3): 544-551. [Google Scholar]

- 19. Gulshan V, Peng L, Coram M, et al. Development and validation of a deep learning algorithm for detection of diabetic retinopathy in retinal fundus photographs[J]. JAMA, 2016, 316(22): 2402-2410. [DOI] [PubMed] [Google Scholar]

- 20. Gargeya R, Leng T. Automated identification of diabetic retinopathy using deep learning[J]. Ophthalmology, 2017, 124(7): 962-969. [DOI] [PubMed] [Google Scholar]

- 21. Goyal M, Reeves ND, Rajbhandari S, et al. Robust Methods for Real-Time Diabetic Foot Ulcer Detection and Localization on Mobile Devices[J]. IEEE J Biomed Health Inform, 2019, 23(4): 1730-1741. [DOI] [PubMed] [Google Scholar]

- 22. Chino DYT, Scabora LC, Cazzolato MT, et al. Segmenting skin ulcers and measuring the wound area using deep convolutional networks[J]. Comput Methods Programs Biomed, 2020, 191(2): 105376. [DOI] [PubMed] [Google Scholar]