RESUME

Introduction: Le débriefing constitue l’étape fondamentale du processus d’apprentissage lors de l’enseignement par simulation. Le guide Debriefing Assessment for Simulation in Healthcare (DASH), est un outil destiné à évaluer et développer les compétences en débriefing des formateurs utilisant la simulation en santé. Objectif: Evaluer le débriefing en simulation sur mannequin de haute-fidélité dans la gestion d’urgence cardiologique par l’outil DASH, version étudiant. Méthodes: Il s’agissait d’une étude bicentrique, prospective, transversale et évaluative incluant cinq groupes d’étudiants en première année de deuxième cycle d’études médicales effectuant leur stage au sein des services de cardiologie de l’hôpital Habib Thameur et de l’hôpital des Forces de Sécurité Intérieure de La Marsa lors du premier semestre de l’année universitaire 2021-2022. Le scénario de simulation a comporté le diagnostic et la prise en charge en urgence d’un bloc auriculo-ventriculaire syncopal dégénératif.Résultats: Quarante-quatre étudiants avaient rempli le formulaire d’évaluation DASH (28 sexe féminin, 16 sexe masculin). Selon les étudiants, les formateurs avaient maintenu un climat favorable à l’apprentissage (6,5±0,74). Ils avaient conduit le débriefing de manière structurée (6,35±0,75). Ils avaient suscité l’engagement dans l’échange amenant l’apprenant à analyser sa performance (6,01±1,03). Ils avaient identifié efficacement les points forts de l’apprenant et ses points à améliorer ainsi que leurs raisons (6,39±1,04). Les formateurs avaient aidé l’apprenant à envisager comment améliorer ou maintenir un bon niveau de performance (6,57±0,77). La moyenne globale attribuée pour l’évaluation des formateurs au cours du débriefing était de 6,36±0.88.Conclusion: L’outil DASH permet aux formateurs de mettre en évidence les points forts et les axes de progression dans le débriefing qui constitue l’étape clé de la simulation permettant d’optimiser le processus du raisonnement clinique et l’amélioration de la qualité des soins.

ABSTRACT

INTRODUCTION: Debriefing is the fundamental step in the learning process when teaching by simulation. The Debriefing Assessment for Simulation in Healthcare (DASH) guide is a tool designed to assess and develop the debriefing skills of trainers using healthcare simulation. AIM: To evaluate the debriefing in high-fidelity mannequin simulation in the management of cardiological emergency by the DASH tool, student version. METHODS: This was a bicentric, prospective, cross-sectional and evaluative study including five groups of students in the first year of the second cycle of medical studies completing their internship in the cardiology departments of the Habib Thameur hospital and the Internal Security Forces Hospital of Marsa during the first semester of the 2021-2022 academic year. The simulation scenario included the diagnosis and emergency management of degenerative syncopal atrioventricular block. RESULTS: Forty-four students completed the DASH assessment form (28 female, 16 male). According to the students, the trainers had maintained a climate conducive to learning (6.51±0.74). They had conducted the debriefing in a structured way (6.35±0.75). They had aroused engagement in the exchange leading the learner to analyze his performance (6.01±1.03). They had effectively identified the learner's strengths and areas for improvement as well as their reasons (6.39±1.04). The trainers had helped the learners to consider how to improve or maintain a good level of performance (6.57±0.77). The mean DASH score evaluating the trainers was 6.36±0.88. CONCLUSION: The DASH tool allows trainers to highlight the strengths and areas for improvement in the debriefing, which is the key step in the simulation to optimize the clinical reasoning process and improve the quality of care.

INTRODUCTION

La simulation en sciences de la santé s’est imposée depuis plusieurs années comme une méthode pédagogique incontournable. Elle regroupe un ensemble de modalités ayant en commun une reproduction des caractéristiques de la réalité clinique qui permet d’exercer certaines habiletés et compétences professionnelles dans un cadre sécuritaire et contrôlé [1]. Les étapes d’une simulation clinique du patient comprennent un prébriefing pour préparer les apprenants à la simulation. Les apprenants s’engagent ensuite dans le scénario de simulation, suivi d’un débriefing pour une analyse post-simulation. Le débriefing est un processus intentionnel conçu pour fournir une prise de conscience et un aperçu, ainsi que pour renforcer et transférer l’apprentissage via un exercice d’apprentissage par l’expérience [2-5]. Le débriefing est une étape essentielle de la simulation car c’est là qu’une grande partie de l’apprentissage se produit [2, 6]. Lorsqu’il est effectué efficacement, le débriefing favorise le raisonnement clinique, la pensée critique, les capacités de jugement et la communication par le biais d’un processus d’apprentissage réflexif [2, 3, 7, 8]. Le formateur doit être bien formé et cohérent lors du débriefing afin de s’assurer que l’expérience de simulation de l’apprenant est efficace et transférable dans sa pratique clinique [9].

Récemment, la simulation sur mannequin de haute-fidélité a été intégrée dans l’enseignement à la faculté de médecine de Tunis. Mais peu de données existant sur l’évaluation du débriefing jusque-là.

L’objectif de notre travail était d’évaluer le débriefing en simulation sur mannequin de haute-fidélité dans la gestion d’urgence cardiologique par l’outil DASH (Debriefing Assessment for Simulation in Healthcare), version « étudiant ».

MÉTHODES

Type de l’étude et population:

Il s’agissait d’une étude prospective, bicentrique, transversale et évaluative. Les étudiants en première année de deuxième cycle des études médicales (DCEM1), effectuant leur stage d’externat de cardiologie au courant du premier semestre de l’année universitaire 2021-2022 au sein des services de cardiologie de l’hôpital Habib Thameur et de l’hôpital des Forces de Sécurité Intérieure (FSI) de La Marsa, ont été inclus. Les étudiants qui ont incomplètement remplis les questionnaires d’évaluation du débriefing ont été exclus.

Déroulement des formations pratiques sur mannequin de haute-fidélité :

L’enseignement comportait une séance de trois heures, programmée dans les horaires des stages hospitaliers et réalisée par l’encadrant référent des étudiants et un membre de la sous-unité de simulation de la section de cardiologie. Le scénario utilisé était intitulé « syncope » et avait comme objectif la prise en charge d’un bloc auriculo-ventriculaire syncopal chez un sujet âgé. La séance avait lieu dans les deux dernières semaines du stage hospitalier. Les groupes ont été convoqués au centre de simulation de la Faculté de Médecine de Tunis à une date différente. Le simulateur utilisé était un mannequin type Laerdal SimMan® 3G mannequin,4002 Stavanger (Norway). Le déroulement de la séance de simulation se faisait sur un mode classique comprenant une phase initiale de briefing ayant pour but d’expliciter les objectifs pédagogiques de la séance de formation, ainsi que le rôle de chacun des participants. Puis une phase de mise en situation pratique, durant laquelle trois externes étaient passés sur le mannequin simulateur du patient et les autres étudiants assistaient à l’intervention dans la salle de débriefing voisine via un système de retransmission audio et vidéo. Et enfin une phase de débriefing, au cours de laquelle, le formateur revenait sur le déroulement de la séance en réalisant une synthèse avec les participants, permettant de fixer les connaissances acquises et de dégager les failles à améliorer pour chaque apprenant. Chaque séance durait en moyenne trente minutes. Il a également été rappelé les règles de confidentialité, basées sur un accord oral tacite. Toutes les données colligées durant les sessions de simulations ne pourraient avoir aucune conséquence sur le cursus universitaire des étudiants. Aucun enregistrement vidéo n’a eu lieu.

Phase évaluative:

Evaluation du débriefing par l’outil DASH: A la fin de la séance de simulation, un questionnaire d’évaluation du débriefing via l’outil DASH (version étudiant) était délivré aux étudiants. Cet outil, développé par l’équipe de Harvard du Center for Medical Simulation, est destiné à évaluer et développer les compétences en débriefing des formateurs utilisant la simulation en santé. Il évalue les stratégies et les techniques utilisées par les formateurs pour conduire des séances de débriefing, en se basant sur leurs comportements [10]. Il se compose de 6 éléments cotés sur une échelle de 1 à 7 (note maximale), permettant d’explorer différentes dimensions des pratiques du débriefing. L’élément 1 évalue l’introduction de la séance de simulation (établir un climat favorable à l’apprentissage). Les éléments 2 à 6 s’intéressent au débriefing : • maintenir un climat favorable à l’apprentissage; • conduire le débriefing de manière structurée; • susciter l’engagement dans l’échange; • identifier les écarts de performance et en analyser les causes; • aider les apprenants à atteindre ou maintenir un bon niveau de performance. L’échelle de réponses adoptée est celui de Likert qui s’échelonnait de 1 (Extrêmement inefficace/préjudiciable) à 7 (extrêmement efficace/exceptionnel) : Evaluation globale de la séance de simulation: Un questionnaire de satisfaction était également délivré aux étudiants, comportant 3 questions évaluant la séance: Evaluation de la qualité globale de la séance proposée Evaluation de la durée de la séance de simulation La présence de l’encadrant référant rassurant ou non Et deux questions évaluant : Niveau de connaissance avant et après la séance de simulation

Analyse statistique:

L’analyse statistique a été réalisée à l’aide du logiciel SPSS 20. Les résultats ont été exprimés en moyennes ±écart-type. Les comparaisons des moyennes ont été effectuées par le test t pour échantillons appariés.

Considérations éthiques:

Un consentement oral de tous les étudiants inclus dans cette étude a été obtenu pour mener ce travail. Il n’y avait eu aucun conflit d’intérêts.

RÉSULTATS

Population:

Trois groupes de dix externes chacun ayant réalisé leur stage au sein du service de cardiologie de l’hôpital Habib Thameur et deux groupes de sept externes chacun ayant réalisé leur stage au sein du service de cardiologie de l’hôpital des Forces de Sécurité Intérieure de La Marsa lors du premier semestre de l’année universitaire 2021- 2022 ont participé à notre étude.

Quarante-quatre externes ont été inclus dans l’étude (28 sexe féminin, 16 sexe masculin). Cinq externes ont joué le rôle de décideur et 10 externes ont joué le rôle de collaborateur au cours de la séquence de simulation.

Evaluation du briefing de la séquence de simulation:

La note moyenne attribuée à l’évaluation du briefing, élément 1 de l’outil DASH, était de 6,05 ±0.99. Le score moyen de chaque comportement de l’élément 1 dédié à l’évaluation du briefing est dans le tableau 1.

Tableau 1 : Evaluation du briefing .

|

Comportement |

Score Moyen |

Ecart type |

Extrêmes |

|

Elément 1 : le formateur a établi un climat favorable à l’apprentissage |

6,36 |

±0,78 |

5-7 |

|

Le formateur s’est présenté, a décrit l’environnement de la simulation, expliqué ce qui était attendu au cours de la séance, et annoncé les objectifs pédagogiques |

6 |

±1,05 |

3-7 |

|

Le formateur a expliqué les points forts et les points faibles de la simulation et m’a indiqué ce que je pouvais faire pour tirer le meilleur parti d’une expérience de simulation clinique |

5,32 |

±1,47 |

1-7 |

|

Le formateur a précisé les détails logistiques, comme l’emplacement des toilettes, les possibilités de restauration, le déroulement de la journée, … |

6,52 |

±0,69 |

5-7 |

|

Le formateur m’a encouragé(e) à exprimer mes réflexions et mes questions au sujet de la simulation et du débriefing à venir et m’a rassuré(e) sur le fait que je ne serais ni mortifié(e) ni humilié(e) dans cet exercice |

6,05 |

±0,99 |

- |

Evaluation du débriefing par l’Outil DASH:

Les éléments 2 à 6 de l’outil DASH évaluent le débriefing. L’élément 2 qui évalue le maintien d’un climat favorable à l’apprentissage par le formateur était jugée presque extrêmement efficace (6,51±0,74). L’élément 3 qui évalue si le formateur avait conduit le débriefing de manière structurée était jugée également presque extrêmement efficace (6,35±0,75). L’élément 4 qui évalue si le formateur avait suscité l’engagement dans l’échange amenant l’apprenant à analyser sa performance était jugée toujours efficace (6,01±1,03). L’élément 5 qui évalue si le formateur avait identifié les points forts de l’apprenant et ses points à améliorer ainsi que leurs raisons était jugé presque extrêmement efficace (6,39±1,04). L’élément 6 qui évalue si le formateur avait aidé l’apprenant à envisager comment améliorer ou maintenir un bon niveau de performance était jugé presque extrêmement efficace (6,57±0,77). La note globale attribuée pour l’évaluation des formateurs au cours du débriefing était de 6,36±0.88, qui est presque extrêmement efficace. Le score moyen de chaque comportement des éléments 2 à 6 est détaillé dans le tableau 2.

Tableau 2 : Evaluation du débriefing/ Eléments à 2 à 6 .

|

Comportement |

Score Moyen |

Ecart type |

Extrêmes |

|

Elément 2: le formateur a maintenu un climat favorable à l’apprentissage |

|

6,36 ±0,75 |

5-7 |

|

Note globale de l’élément 2 |

6,51 |

±0,74 |

- |

|

Elément 3: Le formateur a conduit le débriefing de manière structurée |

|

6,02 ±0,95 |

4-7 |

|

Note globale de l’élément 3 |

6,35 |

±0,75 |

- |

|

Elément 4: Le formateur a suscité l’engagement dans l’échange, ce qui m’a amené(e) à analyser ma performance |

|

6,52 ±0,73 |

4-7 |

|

Note globale de l’élément 4 |

6,01 |

±1,03 |

- |

|

Elément 5: Le formateur a identifié mes points forts et mes points à améliorer ainsi que leurs raisons |

|

6,45 ±1,08 |

2-7 |

|

Note globale de l’élément 5 |

6,39 |

±1,04 |

- |

|

Elément 6: Le formateur m’a aidé à envisager comment améliorer ou maintenir un bon niveau de performance |

|

6,43 ±0,95 |

3-7 |

|

Note globale de l’élément 6 |

6,57 |

±0,77 |

- |

|

Score global du débriefing |

6,36 |

±0,88 |

- |

Evaluation globale de la séance de simulation :

Les apprenants étaient globalement très satisfaits de la séance de simulation avec une moyenne générale (sur cinq) pour les différentes questions posées de 4,25±0,67. La présence de l’encadrant référent au cours de la séance de simulation était très rassurante pour eux. Les réponses à l’auto-questionnaire sont résumées dans le tableau 3.

Table 3 : Statistical Data of Session Quality .

| Comportement | Ecart type | Extrêmes |

|

Qualité globale de la séance |

±0,68 |

3-5 |

|

Evaluation de la durée de la séance de simulation |

±0,99 |

2-5 |

|

La présence de l’encadrant référent |

±0,34 |

4-5 |

Evaluation de la progression du niveau de connaissance après la séquence de simulation :

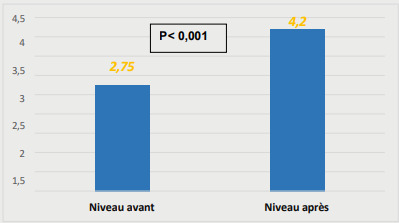

Le niveau de connaissance avant la séquence de simulation était 2,75±0,83. Il était de 4,20±0,7 (p< 0.001) après la séquence de simulation (figure 1).

Figure 1. Progression du niveau de connaissance après la séance de simulation .

DISCUSSION

Dans notre étude, les étudiants ont jugé que les différents éléments de l’outil DASH évaluant le processus de débriefing par le formateur étaient presque extrêmement efficaces (6,36±0.88). Selon les étudiants, les formateurs avaient maintenu très efficacement un climat favorable à l’apprentissage (6,51±0,74). Ils avaient conduit le débriefing de manière structurée (6,35±0,75). Ils avaient suscité efficacement l’engagement dans l’échange amenant l’apprenant à analyser sa performance (6,01±1,03). Ils avaient identifié les points forts de l’apprenant et ses points à améliorer de façon extrêmement efficace. Ils avaient aidé efficacement l’apprenant à envisager comment améliorer ou maintenir un bon niveau de performance (6,39±1,04). Les étudiants étaient satisfaits des apprentissages qu’ils ont effectués dans le cadre de la séance de simulation clinique haute-fidélité (SCHF) avec une moyenne de 4,25 sur 5. La présence de l’encadrant référent au cours de la séance de simulation était très rassurant pour eux.

Nous avons noté une progression significative du niveau de connaissance des étudiants de 2,75±0,83 à 4,20±0,7 (p< 0.001) après la séquence de simulation Notre étude représente la première à évaluer le debriefing à la faculté de médecine de Tunis via l’outil DASH.

Cette étude présente certaines limites. La limite majeure de notre étude est son faible effectif dont la sélection n’était pas aléatoire et intéressait uniquement les étudiants de DCEM1 effectuant leur stage dans les services de cardiologie de l’Hôpital Habib Thameur et de l’Hôpital l’hôpital des Forces de Sécurité Intérieure de La Marsa.

Par ses approches cognitiviste et socioconstructiviste, la simulation permet de faire des apprentissages dans l’action, d’en faire la réflexion et de recevoir une rétroaction rapide face à des problèmes de santé fréquents mais jugés complexes. Le débriefing, l’étape essentielle de la simulation, favorise le raisonnement clinique, la pensée critique, les capacités de jugement et la communication par le biais d’un processus d’apprentissage réflexif [11-14]. Les apprenants ont la possibilité de réfléchir à leur prise de décision, à leur pensée critique et à communication interprofessionnelle par l’auto-analyse et l’évaluation par les pairs.

Un débriefing efficace est la clé du succès des expériences de débriefing de simulation. Le formateur doit être bien formé et cohérent lors du débriefing afin de s’assurer que l’expérience de simulation de l’apprenant est efficace et transférable dans sa pratique clinique [9].

Plusieurs études se sont intéressées à l’élaboration de scénarii de simulation et l’évaluation de l’apprenant plutôt que sur la capacité et la cohérence du formateur à débriefer un scénario de simulation [7, 9, 15]. Le débriefing après une simulation est une stratégie éducative relativement nouvelle dans l’enseignement des soins de santé. Les compétences requises pour être un formateur efficace diffèrent de celles requises pour être un éducateur efficace [16]. Les éducateurs peuvent éprouver des difficultés lors de la transition d’une formation centrée sur l’instructeur à une animation centrée sur l’apprenant pour débriefer efficacement les apprenants après une simulation clinique de patient.

L’évaluation formative régulière des formateurs peut se faire à l’aide d’outils d’évaluation ou de programmes de développement du corps professoral ciblés [17]. Ces outils d’évaluation de l’efficacité et de la qualité du débriefing doivent être validés et fiables et doivent évaluer toutes les modalités du débriefing, tous les intervenants et tous les éléments du débriefing (contenu, structure, méthode, débriefer, temps, environnement, modalité). Différentes échelles d’évaluation sont à disposition (DASH, OSAD, DES, PETQ, PADI). Elles ont été développées dans une perspective d’amélioration des pratiques pédagogiques. Elles sont conçues pour aider l’évaluation et le développement des compétences nécessaires à la conduite du débriefing (auto-évaluation, évaluation par les pairs, les apprenants et les évaluateurs) [18].

Une équipe de chercheurs américains du Centre de simulation médicale de Boston, a développé en 2010 une échelle d’évaluation comportementale scorée, le DASH (Debriefing Assessment for Simulation in Healthcare) [10]. C’est un outil d’évaluation des stratégies et techniques utilisées pour conduire le débriefing à partir de l’observation des comportements et attitudes des formateurs. Le DASH identifie les comportements adaptés pour réaliser un débriefing efficace et ceux caractérisant des débriefings à améliorer [18]. Il existe trois versions du DASH. L’une est conçue pour les formateurs eux-mêmes afin qu’ils s’auto-évaluent, une autre est destinée aux apprenants pour qu’ils évaluent leurs formateurs, la dernière s’adresse aux évaluateurs des formateurs [19, 20]. Pour chacune des trois versions, il existe une forme longue et une forme courte [10, 18]. La forme longue de l’outil DASH « version étudiant » note les formateurs sur les six éléments du DASH et évaluent les comportements associés à chaque élément [ 10 , 18]. Ainsi, nous retrouvons un total de 23 comportements associés aux éléments. C’est la forme qu’on a utilisé pour notre étude. Le DASH – Version Etudiant -forme longue peut être rempli en 5 à 7 minutes environ et fournit des informations précises en termes de feedback pour le formateur. Le DASH, version étudiant - forme courte note les formateurs de façon globale sur les six éléments du DASH. Il peut être effectué en moins de 3 minutes, mais n’est pas aussi précis que la forme longue en termes de feedback pour le formateur [10, 18]. Le DASH peut être utilisé pour évaluer l’introduction d’une séance de simulation (élément 1) et le débriefing post-simulation (éléments 2 à 6). La mise en place d’un climat propice à l’apprentissage affecte de manière significative les activités ultérieures [18]. Ainsi, évaluer l’introduction permettra d’enrichir la signification du score global. Néanmoins, le DASH est conçu pour donner des scores significatifs même quand il n’est possible d’évaluer que les éléments 2 à 6 [18]. Plusieurs études ont utilisé l’échelle DASH pour évaluer la pertinence des méthodes de débriefing pour l’apprentissage de l’apprenant [19-33]. Le DASH moyen dans notre étude était de 6,36±0.88. Également, Durand et al ont étudié l’intérêt de la grille DASH pour l’évaluation de la qualité des débriefings au cours d’un programme de simulation autour de la réanimation du nouveau-né en salle de naissance [22]. Le DASH moyen a été évalué à 6,6/7 par les apprenants, validant ainsi le cadre pédagogique du programme.

Le DASH est conçu pour permettre l’évaluation du débriefing de disciplines et de cours variés, impliquant un nombre variable de participants et un large éventail d’objectifs pédagogiques. Il est valable dans des contextes variés, avec diverses contraintes physiques et temporelles [18, 19].

C’est un outil d’utilisation facile et rapide qui n’est pas associé à une méthode de débriefing particulière [19]. Il est fondé sur des données probantes de la littérature et sur des recommandations de bonnes pratiques du débriefing émanant d’un groupe d’experts [19 , 22, 25, 27]. Les tests psychométriques montrent que DASH est une échelle valide et fiable qui est largement utilisée pour évaluer objectivement le débriefing [19, 27, 35, 36]. Brett-Fleegler M a démontré sa cohérence interne (coefficient alpha de Cronbach (CA) global satisfaisant à 0.89) et sa fiabilité sur les évaluations inter-juges (forte reproductibilité inter- évaluateur : coefficient de corrélation intra-classe (ICC) globale à 0,74 et variant entre 0.57 à 0.68 dans les sous-sections) [33]. Dreifuerst a montré également sa fiabilité et sa validité avec un CA à 0.82 [50]. Fey MK aussi a démontré aussi la fiabilité et la validité de l’outil DASH avec un CA à 0.89, un ICC global à 0.74 et un ICC individual variant de 0.57 à 0.68) [21 ].

Son intérêt est limité dans l’évaluation solitaire mais il est un support valide permettant un « débriefing de débriefing collectif », entre formateurs en fin de session [22]. Le DASH s’inscrit dans une perspective de certification des centres de simulation et des formateurs parce qu’il est au service de la qualité pédagogique [18].

Bien que du point du vue de l’évaluation, cette échelle contient des éléments subjectifs, elle reste un guide utile pour être sûr que les facilitateurs respectent les principes de débriefing de haute qualité [19, 35]. A l’usage, l’attention que les facilitateurs devront porter aux différents éléments de DASH variera grandement selon le type de l’apprenant. Un degré variable d’emphase peut être nécessaire sur les différents éléments de l’échelle selon le résultat du scénario ou le niveau d’expérience des apprenants. Par exemple, avec certains apprenants, le débriefeur devra faire en sorte que le debriefing reste structuré afin qu’aucun point ne soit oublié, tandis qu’avec d’autres, les facilitateurs devront mettre plus d’effort dans l’engagement de la discussion pour réellement explorer le raisonnement ou le rationnel derrière certaines actions des participants [36].

Van Malleghem Christine à travers une revue de la littérature des outils d’aide à l’évaluation de la conduite de débriefing a permis de confirmer l’existence d’outils d’évaluation valides et fiables [18]. Néanmoins ces outils ne peuvent être utilisés dans toutes les situations. Le DASH a été considéré parmi les outils valides et fiables qui ne sont pas associés à une méthode de débriefing comme le DMLSE et le PETQ25 [18]. Le DASH peut servir de support aux praticiens qui souhaitent entrer dans une démarche d’analyse de leurs pratiques pédagogiques, condition nécessaire à leur progression [18]. De par ses différentes versions, DASH évalue les débriefeurs selon différentes perspectives [18].

On ne sait que peu de chose sur le lien qui existe entre le score DASH et l’atteinte d’objectifs d’apprentissage spécifiques tels que l’amélioration des connaissances, des compétences et des comportements. Bien qu’il soit difficile de démontrer une corrélation directe entre débriefing efficace (évalué par un outil d’évaluation du débriefing) et une performance améliorée dans les environnements cliniques, les recherches futures devraient au moins viser à établir une corrélation entre l’acquisition des connaissances, l’amélioration des compétences et ou des comportements dans l’environnement simulé [37]. L’impact sur l’outcome du patient n’est encore que trop peu étudié [ 25 , 37].

La satisfaction des étudiants à l’égard de leurs apprentissages dans un contexte de simulation est un indicateur significatif de leur préparation clinique [38]. Dans notre étude, les étudiants étaient satisfaits des apprentissages qu’ils ont effectués dans le cadre de la séance de SCHF. La moyenne obtenue pour la mesure de la satisfaction par les 44 externes était de 4,25 (échelle sur 5). Plusieurs auteurs ont examiné le niveau de satisfaction des étudiants par rapport aux apprentissages réalisés dans le cadre de la SCHF. Ils ont constaté que les étudiants étaient statistiquement plus satisfaits des apprentissages fondés sur la SCHF [39-42].

Perspectives:

L’outil DASH permet aux formateurs de mettre en évidence les points forts et les axes de progression dans le débriefing des séances de simulation. Les perspectives seraient d’intégrer l’enseignement par la simulation dans les différentes spécialités à la Faculté de Médecine de Tunis et faire une évaluation régulière des pratiques par l’outil DASH permettant de soulever les points faibles du débriefing à améliorer.

CONCLUSION

A l’issue de notre travail, le débriefing constitue l’étape clé de la simulation permettant ainsi d’optimiser le processus du raisonnement clinique et l’amélioration de la qualité des soins. Le rôle du formateur est primordial dans ce processus d’apprentissage actif. L’outil DASH permet aux formateurs de mettre en évidence les points forts et les axes de progression dans le débriefing des séances de simulation.

References

- Valler-Jones T, Meechan R, Jones H. Simulated practice--a panacea for health education? Br J Nurs. 2011;20(10):629–631. doi: 10.12968/bjon.2011.20.10.628. [DOI] [PubMed] [Google Scholar]

- Arafeh JM, Hansen SS, Nichols A. Debriefing in simulated-based learning: facilitating a reflective discussion. J Perinat Neonatal Nurs. 2010;24(4):302–309. doi: 10.1097/JPN.0b013e3181f6b5ec. [DOI] [PubMed] [Google Scholar]

- Miller KK, Riley W, Davis S, Hansen HE. In situ simulation: a method of experiential learning to promote safety and team behavior. J Perinat Neonat Nurs. 2008;22(2):105–113. doi: 10.1097/01.JPN.0000319096.97790.f7. [DOI] [PubMed] [Google Scholar]

- Morgan PJ, Tarshis J, LeBlanc V, Cleave-Hogg D, DeSousa S, Haley MF, Herold-McIlroy J, Law JA. Efficacy of high-fidelity simulation debriefing on the performance of practicing anesthetists in simulated scenarios. Br J Anaesth. 2009;103(4):531–537. doi: 10.1093/bja/aep222. [DOI] [PubMed] [Google Scholar]

- Warrick D, Hunsaken PL, Cook CW, Altman S. Debriefing experiential learning exercises. J Exp Learn Simul. 1979;1:91–100. [Google Scholar]

- Zigmont JJ, Kappus LJ, Sudikoff SN. The 3D model of debriefing: defusing, discovering, and deepening. Semin Perinatol. 2011;35:52–58. doi: 10.1053/j.semperi.2011.01.003. [DOI] [PubMed] [Google Scholar]

- Dreifuerst K. The essentials of debriefing in simulation learning: a concept analysis. Nurs Educ Prospect. 2009;30(2):109–114. [PubMed] [Google Scholar]

- INASCL Board of Directors Standard VI: the debriefing process. Clin Simul Nurs. 2011;7(4 suppl):S16–S17. [Google Scholar]

- https://www.nursingsimulation.org/article/S1876-1399(11)00066-1/fulltext [Google Scholar]

- Fanning RM, Gaba DM. The role of debriefing in simulation-based learning. Simul Health. 2007;2(2):115–125. doi: 10.1097/SIH.0b013e3180315539. [DOI] [PubMed] [Google Scholar]

- Simon R, Rudolph JW, Raemer DB. Harvard Medical School; 2009. Debriefing assessment for simulation in healthcare.https://harvardmedsim.org/debriefing-assessment-for-simulation-in-healthcare-dash/ [Google Scholar]

- Jeffries P. A framework for designing implementing and evaluating simulations used as teaching strategies in nursing. Nurs Educ Perspect. 2005;26(2):96–103. [PubMed] [Google Scholar]

- Jeffries P. Technology trends in nursing education: next steps. J Nurs Educ. 2005;44(1):3–4. doi: 10.3928/01484834-20050101-01. [DOI] [PubMed] [Google Scholar]

- Parker B, Myrick F. A critical examination of high-fidelity human patient simulation within the context of nursing pedagogy. Nurse Educ Today. 2008;29(3):322–329. doi: 10.1016/j.nedt.2008.10.012. [DOI] [PubMed] [Google Scholar]

- Zairi I, Mzoughi K, Ben Mrad I, Allouch E, Kamoun S, Ben Moussa F. Intérêt de la simulation dans l’apprentissage du raisonnement clinique. Tunis Med. 2020 Jun;98(6):466–474. [PubMed] [Google Scholar]

- Parker B, Myrick F. Transformative learning as a context for the human patient simulation. J Nurs Educ. 2010;49(6):326–332. doi: 10.3928/01484834-20100224-02. [DOI] [PubMed] [Google Scholar]

- Dismukes RK, Gaba DM, Howard SK. So many roads: facilitated debriefing in healthcare. Simul Healthc. 2006;1(1):23–25. doi: 10.1097/01266021-200600110-00001. [DOI] [PubMed] [Google Scholar]

- Kolbe M, Grande B, Spahn DR. Briefing and debriefing during simulation-based training and beyond: Content, structure, attitude and setting. Best Pract Res Clin Anaesthesiol. 2015 Mar;29(1):87–96. doi: 10.1016/j.bpa.2015.01.002. [DOI] [PubMed] [Google Scholar]

- Van Malleghem C. Evaluation de la qualité du débriefing en simulation de santé. Available from :http://www.medesim.fr/wp-content/doc/memoire/diu2019-cvanmalleghem-meemoire.pdf. 2019.

- Brett-Fleegler M, Rudolph J, Eppich W. Debriefing assessment for simulation in healthcare. Development and psychometric properties. Simul Healthc. 2012;7:288–294. doi: 10.1097/SIH.0b013e3182620228. [DOI] [PubMed] [Google Scholar]

- Ben Amor I, Hentati Y, Gargouri J. Grilles d’évaluation des formateurs en simulation en santé 2018. JIM Sfax. 2018;28:1–9. http://www.medecinesfax.org/useruploads/files/jim-28.pdf [Google Scholar]

- Fey MK, Scrandis D, Daniels A, Haut C. Learning through debriefing: students’ perspectives. Clinical Simulation in nursing. 2014;10:e249–e256. https://www.sciencedirect.com/science/article/abs/pii/S1876139914000103 [Google Scholar]

- Durand C, Secheresse T, Leconte M. The use of the Debriefing Assessment for Simulation in Healthcare (DASH) in a simulation-based team learning program for newborn resuscitation in the delivery room. Arch Pediatr. 2017;24(12):1197–1204. doi: 10.1016/j.arcped.2017.09.017. [DOI] [PubMed] [Google Scholar]

- Ahmed RA, Atkinson SS, Gable B, Yee J, Gardner AK. Coaching From the Sidelines: Examining the Impact of Teledebriefing in Simulation-Based Training. Simul Healthc. 2016;11(5):334–339. doi: 10.1097/SIH.0000000000000177. [DOI] [PubMed] [Google Scholar]

- Loo ME, Krishnasamy C, Lim WS. Considering Face, Rights, and Goals: A Critical Review of Rapport Management in Facilitator-Guided Simulation Debriefing Approaches. Simul Healthc. 2018;13(1):52–60. doi: 10.1097/SIH.0000000000000258. [DOI] [PubMed] [Google Scholar]

- Alhaj A, Musallam E. Debriefing quality evaluation in nursing simulation-based education : an integrative review. medesim.fr. 2018;16:15–24. http://www.medesim.fr/wp-content/doc/memoire/diu2019-cvanmalleghem-meemoire.pdf [Google Scholar]

- Kalpokdjian A, Martin A, Measso S, al Evaluation de la qualité du débriefing pour la simulation en santé par l’utilisation de l’échelle DASH. Paris. 2015. https://www.sfmu.org/upload/70_formation/02_eformation/02_congres/Urgences/urgences2015/donnees/communications/resume/posters/P062.pdf

- Kolbe M, Weiss M, Grote G, Knauth A, Dambach M, Spahn DR, et al TeamGAINS: a tool for structured debriefings for simulation-based team trainings. BMJ Qual Saf. 2013;22(7):541–553. doi: 10.1136/bmjqs-2012-000917. [DOI] [PubMed] [Google Scholar]

- Rudolph JW, Palaganas J, Fey M, Morse C, Onello R, Dreifuerst K, et al A DASH to the top: educator debriefing standards as a path to practice readiness for nursing students. Clin Sim in Nurs. 2016;12(9):412–417. https://core.ac.uk/download/pdf/326327570.pdf [Google Scholar]

- Brown DK, Wong AH, Ahmed RA. Evaluation of simulation debriefing methods with interprofessional learning. J Interprof Care. 2018 Jul;:1–3. doi: 10.1080/13561820.2018.1500451. [DOI] [PubMed] [Google Scholar]

- Fraser KL, Meguerdichian MJ, Haws JT, Grant VJ, Bajaj K, Cheng A, et al Cognitive Load Theory for debriefing simulations: implications for faculty development. Adv Simul (Lond) 2018 Dec;3:28. doi: 10.1186/s41077-018-0086-1. [DOI] [PMC free article] [PubMed] [Google Scholar]

- Roh YS, Kelly M, Ha EH. Comparison of instructor-led versus peer-led debriefing in nursing students. Nurs Health Sci. 2016 Jun;18(2):238–245. doi: 10.1111/nhs.12259. [DOI] [PubMed] [Google Scholar]

- Scherer YK, Foltz-Ramos K, Fabry D, Chao YY. Evaluating Simulation Methodologies to Determine Best Strategies to Maximize Student Learning. J Prof Nurs. 2016;32(5):349–357. doi: 10.1016/j.profnurs.2016.01.003. [DOI] [PubMed] [Google Scholar]

- Morse K. Structured model of debriefing on perspective transformation for NP students. Clin Sim in Nurs. 2015;11(3):172–179. https://www.infona.pl/resource/bwmeta1.element.elsevier-eebac7dea194-3d08-b9b8-adbb41926a5b [Google Scholar]

- Waznonis AR. Methods and evaluations for simulation debriefing in nursing education. J Nurs Educ. 2014;53(8):459–465. doi: 10.3928/01484834-20140722-13. [DOI] [PubMed] [Google Scholar]

- Oriot D, Alinier G. Paris : Elsevier. 2019. La simulation en santé - Le débriefing clés en mains.https://www.elsevier.com/fr-fr/connect/etudes-de-medecine/la-simulation-en-sante-le-debriefing-cles-en-mains [Google Scholar]

- Dreifuerst KT. Using debriefing for meaningful learning to foster development of clinical reasoning in simulation. J Nurs Educ. 2012;51(6):326–333. doi: 10.3928/01484834-20120409-02. [DOI] [PubMed] [Google Scholar]

- Johnston S, Coyer FM, Nash R. Kirkpatrick’s Evaluation of Simulation and Debriefing in Health Care Education: A Systematic Review. J Nurs Educ. 2018;57(7):393–398. doi: 10.3928/01484834-20180618-03. [DOI] [PubMed] [Google Scholar]

- Fountain RA, Alfred D. Student satisfaction with high-fidelity simulation: does it correlate with learning styles? Nurs Educ Perspect. 2009;30(2):96–98. [PubMed] [Google Scholar]

- Wilson R, Klein JD. Design, implementation and evaluation of a nursing simulation: a design and development research study. The Journal of Applied Instructional Design. 2012;2(1):57–68. [Google Scholar]

- Laschinger S, Medves J, Pulling C, McGraw DR, Waytuck B, Harrison MB, Gambeta K. Effectiveness of simulation on health profession students’ knowledge, skills, confidence and satisfaction. Int J Evid Based Healthc. 2008;6(3):278–302. doi: 10.1111/j.1744-1609.2008.00108.x. [DOI] [PubMed] [Google Scholar]

- Jeffries P. Designing simulation for nursing education. Annual Review of Nursing Education. 2006;4:161–177. [Google Scholar]

- Smith S, Roehrs C. High-fidelity simulation: Factors correlated with nursing student satisfaction and self-confidence. Nurs Educ Perspect. 2009;30(2):74–78. [PubMed] [Google Scholar]